|

|

КОЛИЧЕСТВЕННАЯ ОЦЕНКА ИНФОРМАЦИИ2.1. Количество информации при равновероятности состояний Сообщения разнятся как по своей природе, так и по содержанию и по назначению. В связи с этим возникают трудности в оценке количества информации, которое содержится в сообщениях. Количество информации должно определяться через нечто общее, объективно присущее всему многообразию различной информации, оставаясь при этом созвучным нашим интуитивным представлениям, связанным с фактом получения информации. Этим общим, характеризующим фактом получения произвольной информации, является, во-первых, наличие опыта. Всякая информация добывается нами в результате опыта и только опыта. Во-вторых, до опыта должна существовать некоторая неопределенность в том или ином исходе опыта. Таким образом, до опыта всегда имеется большая или меньшая неопределенность в интересующей нас ситуации. После опыта ситуация становится более определенной и на поставленный вопрос мы можем ответить либо однозначно, либо число возможных ответов уменьшится и, следовательно, уменьшится существовавшая ранее неопределенность. Количество уменьшенной неопределенности после опыта, очевидно, можно отождествить с количеством получаемой информации в результате опыта. Теперь ясно, что для установления формулы для вычисления количества информации необходимо уметь вычислять неопределенность некоторой ситуации до и после опыта. Разность между этими количествами неопределенности и дает нам искомое количество информации, полученное от такого опыта. К количеству информации (неопределенности до опыта) можно предъявить три интуитивных требования. 1. Количество получаемой информации больше в том опыте, у которого большее число возможных исходов. Обозначая количество информации буквой I, а число возможных исходов n, первый постулат запишем в виде:

2. Опыт с единственным исходом несет количество информации, равное нулю, т.е.

3. Количество информации от двух независимых опытов равно сумме количества информации от каждого из них:

Очевидно, единственной функцией аргумента n, удовлетворяющей трем поставленным условиям, является логарифмическая. Итак, количество информации от опыта с N исходами при условии, что после опыта неопределенность отсутствует:

Выбор постоянной С и основания логарифмов здесь несущественен, так как определяет только масштаб на единицу неопределенности. Поэтому положим С = 1, а = 2. Тогда

Указанная мера была предложена Р. Хартли в 1928г. для количественной оценки способности системы хранить или передавать информацию. Такая мера удовлетворяет требованию аддитивности. Емкость устройства состоящего из n ячеек, имеющего N = mn состояний, равна емкости одной ячейки, умноженной на число ячеек:

За единицу измерения емкости принята двоичная единица или bit, равная емкости одной ячейки с двумя возможными состояниями. Следует отметить, что мера количества информации в виде (2.6) относится к весьма частному случаю, когда после опыта неопределенности в исходе нет и все исходы равновероятны. Дальнейшее развитие теории информации шло в направлении учета статистических характеристик. Если от источника информации по каналу связи передавать сообщение о событии, априорная вероятность которого на передающей стороне равна Р 1, то после приема сообщения апостериорная вероятность этого события для приемника информации равна Р 2 и количество информации, полученное в результате приема сообщения, будет

Для канала связи без помех и искажений прием сообщения становится достоверным событием, т.е. вероятность Р 2 = 1, тогда из (2.7) следует, что

Из (2.8) следует, что чем меньше вероятность Р 1, тем больше неопределенность исхода, т.е. тем большее количество информации содержится в принятом сообщении. Значение Р 1 находится в пределах Количество информации

Энтропия ансамбля

Ансамблем называется полная совокупность состояний с вероятностями их появлений, составляющими в сумме единицу:

причем Пусть имеет место N возможных исходов опыта, из них k разных, и i- й исход (i = 1, 2,..., k) повторяется ni раз и вносит информацию, количество которой оценивается как Ii . Тогда средняя информация, доставляемая одним опытом, равна

Но количество информации в каждом исходе согласно (2.8) будет

Тогда

Но отношение

Подставляя (2.13) в (2.12), получим

Полученную величину К. Шеннон назвал энтропией и обозначил буквой Н, бит:

Энтропия Н представляет собой логарифмическую меру беспорядочности состояния источника сообщений и характеризует степень неопределенности состояния этого источника. Получение информации – это процесс раскрытия неопределенности. В информационных системах неопределенность снижается за счёт принятой информации, поэтому численно энтропия Н равна среднему количеству информации, несомой произвольным исходом xi, т.е. является количественной мерой информации. Если все k различных состояний источника равновероятны, то

энтропия максимальна и из (2.14) имеем

Нетрудно заметить, что в частном случае при равновероятных сообщениях формулы (2.14) и (2.5) совпадают. Совпадение оценок количества информации по Шеннону и Хартли свидетельствуют о полном использовании информационной емкости системы. В случае неравных вероятностей количество информации по Шеннону меньше информационной емкости системы. Энтропия объединения Объединением называется совокупность двух и более взаимозависимых ансамблей дискретных случайных переменных. Рассмотрим объединение, состоящее из двух ансамблей X и Y, например из двух дискретных измеряемых величин, связанных между собой вероятностными зависимостями. Объединение ансамблей характеризуется матрицей P (X, Y) вероятностей P (xi, yi) всех возможных комбинаций состояний

Cуммируя столбцы и строки матрицы (2.16), получим

где Вероятности P (xi, yj) совместной реализации взаимозависимых состояний xi и yi можно выразить через условные вероятности P (xi /yj) или P (yj /xi) в соответствии с тем, какие состояния принять за причину, а какие – за следствие.

где P (xi / yj) – вероятность реализации состояний xi ансамбля X при условии, что реализовалось состояние yj ансамбля Y; P (yj / xi) – вероятность реализации состояний yj ансамбля Y при условии, что реализовалось состояние xi ансамбля X. Тогда выражение для энтропии объединения в соответствии с (2.14) принимает вид:

где

При усреднении по всем состояниям ансамбля X получаем среднюю неопределенность, приходящуюся на одно состояние ансамбля Y при известных состояниях ансамбля X:

Величину H (Y / X) называют полной условной или просто условной энтропией ансамбля Y по отношению к ансамблю X. Подставляя (2.21) в (2.19), получаем

Выражая

где

и Таким образом, энтропия объединения двух статистически связанных ансамблей X и Y равна безусловной энтропии одного ансамбля плюс условная энтропия другого относительно первого. В случае статистической независимости ансамблей X и Y имеют

Тогда

Учитывая, что

получим

Свойства энтропии

2.4.1. Энтропия всегда неотрицательна, так как значения вероятностей выражаются дробными величинами, а их логарифмы – отрицательными величинами (2.14). 2.4.2. Энтропия равна нулю в том крайнем случае, когда одно событие равно единице, а все остальные – нулю. Это положение соответствует случаю, когда состояние источника полностью определено. 2.4.3. Энтропия имеет наибольшее значение при условии, когда все вероятности равны между собой (2.15). 2.4.4. Энтропия источника Х с двумя состояниями х 1 и х 2 изменяется от нуля до единицы, достигая максимума при равенстве их вероятностей

Р (х 1) = Р = Р (х 2) = 1 - Р = 0,5.

График зависимости Н (Х) в функции Р:

Н (Х) = - [ P log P + (1 -P)log(1 -P)], (2.27)

приведен на рис. 2.1. Отметим, что энтропия непрерывно зависит от вероятности отдельных состояний, что непосредственно вытекает из непрерывности функции -P log P.

Рис. 2.1. Зависимость Н (Х) в функции Р

2.4.5. Энтропия объединения нескольких статистически независимых источников информации равна сумме энтропий исходных источников

H (X, Y, Z,..., W) = H (X) + H (Y) + H (Z) +... + H (W). (2.28) 2.4.6. Энтропия объединения двух статистически связанных ансамблей X и Y равна

2.4.7. Энтропия объединения любого числа зависимых ансамблей определяется из выражения

2.4.8. Энтропия не зависит от значений, принимаемых случайными величинами, а зависит только от вероятностей их появления (2.14). 2.4.9. Если события xi и yj статистически независимы при любых i и j, то H (Y / X) = H (Y) и H (X / Y) = H (X). (2.30) Таким образом, сведения о результатах выбора состояний из одного ансамбля не снижает неопределенности выбора состояний из другого ансамбля. Если имеет место однозначная связь в реализациях состояний H (Y / X) = 0, H (X / Y) = 0. (2.31) Действительно, условные вероятности P (xi / yj) и P (yj, xi) в этом случае принимают значения, равные нулю или единице. Поэтому все слагаемые, входящие в выражения (2.20) и (2.25), для частных условных энтропий равны нулю. Тогда в соответствии с (2.21) и (2.24) условные энтропии равны нулю. Равенства (2.31) отражают факт отсутствия дополнительной неопределенности при выборе событий из второго ансамбля. Уяснению соотношений между рассмотренными энтропиями дискретных источников информации (ансамблей) соответствует их графическое отображение (рис. 2.2).

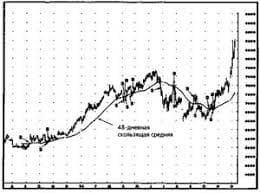

Рис. 2.2. Энтропия объединения   Что вызывает тренды на фондовых и товарных рынках Объяснение теории грузового поезда Первые 17 лет моих рыночных исследований сводились к попыткам вычислить, когда этот...  Живите по правилу: МАЛО ЛИ ЧТО НА СВЕТЕ СУЩЕСТВУЕТ? Я неслучайно подчеркиваю, что место в голове ограничено, а информации вокруг много, и что ваше право...  ЧТО ПРОИСХОДИТ, КОГДА МЫ ССОРИМСЯ Не понимая различий, существующих между мужчинами и женщинами, очень легко довести дело до ссоры...  ЧТО ТАКОЕ УВЕРЕННОЕ ПОВЕДЕНИЕ В МЕЖЛИЧНОСТНЫХ ОТНОШЕНИЯХ? Исторически существует три основных модели различий, существующих между... Не нашли то, что искали? Воспользуйтесь поиском гугл на сайте:

|