|

|

Работа со сложными внешними средами.Еслироботыпредназначеныдляманипулированиявсложныхименяющихсяусловиях, то они должны уметь действовать с объектами вне поля их зрения без прерывания выполнения основной задачи. Будущие исследования будут направлены на работу агента в различных окружениях, и фаза пост-обучения должна быть увеличена.

Исследоватьвыгодыилирасходы использования углов сочленений Вразделе 6.4 былоупомянуто о том, что добавление углов сочленений в виде входов в нейросеть не ускоряло обучение относительно сети работающей только на основе изображений. Будущая работа может исследовать эту особенность, уменьшить размер изображений, чтобы входы с углами сочленений приобрели бОльшее значение.

Исследовать алгоритм O-Greedy В разделе 6.7.2 представлен новый алгоритм сокращения времени обучения, применимый к нейросети со входами данными только из углов сочленений. Дальнейшая работа помогла бы выяснить как O-Greedyработает при использовании изображений в качестве входных данных, и выявила бы возможность уменьшить время обучения с помощью этой техники.

Альтернативы для Глубокого обучения с подкреплением (deepQ-learning) Q-learning хорошо подходит для задач игры в видеоигры и манипуляции роботов. В каких ещё областях этот метод может быть применён? Движение роботов в значительной степени зависит от визуальных данных, чтобы принимать решения, и решение найдено с помощью обучения с подкреплением. Можно было бы расширить существующие исследования в этой области как для 2-ногих [95] [24] [27], так и для 4х-ногих [48] с помощью глубокого Q-learning.Свёрточные нейронные сети не ограничиваются изображениями, они также хорошо себя показали при работе с видео [43] и звуком [74]. Таким образом, можно было бы изучить эффективность глубокого Q-learning, когда эти данные передаются агенту в задачу обучения с подкреплением.

КРИТИЧЕСКАЯ ОЦЕНКА Сильные стороны работы · Обобщаемость. Мы показали, что наши агенты имеют возможность обобщать во время обучения, могут адаптироваться к изменениям в форме цели и могут справляться с добавлением беспорядка, нагромождения объектов. · Сокращение времени обучения. В попытке сократить время обучения мы рассмотрели новые способы для агента изучить его среду. В разделе 6.7.2 предложен O-greedy алгоритм, который сократил время изучения успешных стратегий. Более того, используя промежуточные вознаграждения, мы поощряли агента к более успешным состояниям в короткие промежутки времени. · Симулятор руки Mico – это точная копия реальной руки. Этот инструмент может использоваться во многих других случаях благодаря возможности мгновенных движений и визуальной точности. · Пробовали многочисленные ПО симуляции. В ходе работы воспользовалисьV-REP, ещё 2мя версиями Robox для обучения наших агентов. Каждое из этих ПО симуляции успешно обучалось стратегиям действий, и при этом мы фактически показали, что наши методы распространяются на разные виртуальные среды. · Тесты как в симуляции, так и в реальном мире. Мы первыми применили 3D-моделирование в реальном мире, используя глубокое Q-обучение. Это важная веха на пути к виртуальному обучению, открывает возможности для дальнейших разработок. Слабые стороны работы · Нейро-сетевая архитектура. Помимо одного эксперимента, который мы добавили в конфигурацию робота, нейро-сетевая архитектура не менялась во время всей работы. · Потерянное время в ранних экспериментах. Мы исследовали многие сторонние симуляторы, которые могли бы точно имитировать нашего робота. Однако только после того, как мы начали экспериментировать, мы поняли, что нам не нужны большинство функций, и вместо этого они стали обузой для нашего времени обучения. · Маркировка оси X. Было бы более информативно записывать шаги по времени, а не по эпизодам. Например, сравнивая два метода с точки зрения времени обучения, один из них был более успешен чем другой, и это приводило к тому, что эпизодов у него было больше, хотя количество итераций фактически меньше. Это давало потенциально ошибочные графики. · Результаты теста. При тестировании в обученных средах агенты преуспевали между 50% и 56% случаев. Это прежде всего связано с остановкой экспериментов с самыми ранними признаками обучения, чтобы облегчить начало новых экспериментов. В идеале нам бы хотелось, чтобы каждый эксперимент работал дольше, что, возможно, улучшило скорость успеха. · Камера. Эксперименты были обобщены на разные позиции цели иразные начальные конфигурации роботов, но не были обобщены на разные положения камеры. Это важно, потому что при повторении сцены в реальном мире нельзя гарантировать, абсолютную идентичность положения камеры. · Недостаточные данные на ранних экспериментах главыс ранними экспериментами по сравнению с главой с поздними экспериментами. СРАВНЕНИЕССУЩЕСТВУЮЩИМИТЕХНОЛОГИЯМИ РаботасделанаподвлияниемGoogleDeepMindтренировкиигрывAtari-2600 [64] с помощью обучения с подкреплением [65]. Исходяизприродыихзадачи,они выхватывали несколько кадров и соединяли их для получения состояния. Требовалосьзахватитьдополнительнуюинформацию, которуюневозможнобылополучитьизоднойкадра, например, направление движения мяча при игре в pong. Мыможемполучитьвсюрелевантнуюинформацию из одного кадра. Даннаяработавыполнялосьв 3хизмеренияхисопряженасдругимипроблемами: большеинформациивыводилосьизкадра – позицияобъектаируки, углысочленений и успех/неудача захвата объекта или нет. Болеетого, нейросетьдолжна вывести не толькоxиyкуба, ноещёz — создавалонеобходимостьдействий, за которыми следовало хватание куба. Дополнительноевремярендеринга 3D-окруженияпосравнениюс 2D. Из большого размера пространства конфигураций и сложности задачи следовало то, что вероятность случайного успеха почти нулевая в сравнении с работойDeepMind. Этоделалообучениенамногоболеесложнымитребовалохорошопродуманныхнемедленныхпоощрений в сравнениям с наградами, напрямую генерируемыми игровым счётом Atari. Что DeepMind сделал особенно хорошо в их статье – это был тест множества из 49 игр с использованием одного и тоже алгоритма, архитектуры сети и гипер-параметров, которые демонстрируют гибкость их метода. Если мы имели больше времени, мы бы последовали их примеру и применили работу к большему числу задач и форм, как описано в разделе 8.2. Zhangико. [107] безуспешнопыталисьприменитьнейросеть, натренированнуюнасимуляциидлядостиженияцелейвреальноммире. Задачу, которуюонипыталисьвыполнитьбылазначительнопроще: во-первых, онитренировалиихагентавдвумернойсимуляции (меньшепростр.конфиг.); во-вторых, они использовали руку с 3мя сочленениями по сравнению с нашей с 6ю сочленениями (ещё больше сокр. простр.конфиг.); наконец, цель нашейманипуляциивзахватеиподнятииобъекта по существу более сложная, чем попасть по цели на плоскости. Zhangико. использовалисетьDeepMind [64] смалоймодификацией —сохранив даже ввод в виде 4х изображений в каждый момент времени. Как было описано выше,DeepMind использовали такую технику, потому что они не могли захватить полное состояние в одном кадре. SergeyLevineико. [56] [25] бились над похожимизадачами, но с небольшими заметнымиотличиями. Ихработавключалабольшойспектрзадач: вставка игрушки в куб с дырками разной формы, закручивание крышки бутылки, это некоторые из них. Задачиначиналисьизупрощённого состояния, когдаобъектужебылсхвачен, убираяоднуизсамыхсложныхчастейзадачманипулирования. Вфокусе нашей работы полный цикл задач: определение места, хватание и наконец выполнение действия, например, поднятие. SergeyLevine и ко. Выполняли их задачи с использованием физического робота PR2, который требовал ручного выдачи наград и возвращения к исходному состоянию(reset). НашизадачивыполнялисьвсимуляциирукойMico, котораяпозволяладляобучениябезучителя (unsupervisedlearning) иимелапотенциалнамногобольшегочислаитераций. PintoиGupta [78] сфокусировалисьнапредсказанииположенийдляхватания, чем на выполнении конечных манипуляций, которых достигли мы. Ктомужеиспользованиесвёрточныхнейронныхсетей, их архитектура и выходные данные значительно отличались от нашей модели. Ихсетьсодержаладополнительно 2 свёрточныхслоя, похожихнаAlexNet [49], в то время, как мы использовали архитектуру, похожую наDeepMind [64]. ОБУЧЕНИЕ С ПОДКРЕПЛЕНИЕМ [1] Агент – обучаемыйипринимающий решениясубъект, автономноисследуетоптимальное поведение с помощью попыток и ошибок взаимодействия с окружающей его средой в попытках решить проблему управления. Среда – это всё, что снаружи агента, с чем можно взаимодействовать в течение обучения. Взаданныймоментt, средаиагентнаходятся в состоянии s∈S, которое содержит всю необходимую информацию. Изэтогосостояниямогут быть произведены действия a∈A. После перехода на следующий шаг времени агент получает вознаграждение r∈R и переходит в следующее состояние. Отображение состояний в действия задается стратегией π. Стратегии могут быть детерминированными (одно и то же действие используется для определенного состояния) или вероятностными (действие выбирается путем вычерчивания выборки из распределения по действиям для данного состояния). В зависимости от задачи обучение делится на эпизоды. Эпизодичная задача управления обычно используется в моделях с конечным временем. Число моментов времени может быть сколь угодно большим, но ожидаемая награда эпизода должна сходиться До сих пор мы упоминали, что, продвигаясь к следующему шагу времени, агент получает вознаграждение. Неформально целью агента является максимизация совокупных вознаграждений, которые он получает в долгосрочной перспективе. В общем, агент хочет максимизировать ожидаемый доход, который в простейшем случае является суммой вознаграждений. Тогда, кажется, что вознаграждения, полученные сейчас, стоят того же, что и награды в будущем. Это подводит нас к концепции дисконтирования (отсрочки). Введем параметр γ, который составляет 0 ≤ γ ≤ 1, называемый ставкой отсрочки (discountrate). Это используется для определения текущей стоимости будущих вознаграждений, которые может получить агент. Добавление ставки отсрочки к нашей ожидаемой награды дает формулу общей награды:

Это уравнение говорит нам, что вознаграждение в момент k в будущем взвешивается на γk-1, что соответствует величине награды, если бы мы получили его в настоящее время. При выборе подходящего значения для γ следует проявлять большую осторожность, поскольку он часто качественно изменяет форму оптимального решения [41]. Когдаγ приближается к 0, агент становится близоруким, выбирая действия, которые максимизируют его немедленную награду, что приводит к плохой работе в долгосрочных задачах. Напротив, когда γ приближается к 1, агент становится более дальновидным, что приводит к проблеме, когда он не может отличить стратегии, которые сразу дают большую награду, и те, которые компенсируют ей в далёком будущем. Эпизодичность задачи задаётся путём определениятерминального состояния прекращения действий как специальное поглощающее состояние, которое переходит в себя и генерирует вознаграждение 0.После этого (по достижении определённого числа итераций) агент сбрасывается в стандартное начальное состояние или состояние, выбранное из стандартного распределения начальных состояний. СВОЙСТВО МАРКОВОСТИ В системах обучения с подкреплениемнельзя ожидать, что посостоянию агент может понять всё об окружающей среде. Агент может не знать чего-то, или забыть что-то, что знал. Поэтому в идеальной системе нам нужна сигнатура состояний, которая суммирует прошлые события компактным образом, сохраняя при этом всю соответствующую информацию. Сигнатура, которая сохраняет эту информацию, называется марковским свойством состояния. Формально состояние st называется марковским, тогда и только тогда, когда: P(st+1,rt+1 | st, at) = P(st+1, rt+1 | st, at, rt, st−1, at−1, rt−1,..., r1,s0,a0) (2.3) Текущее состояние среды зависиттолькоотсостояния (посещённого) идействия (произведённого) впредыдущиймоментвремени. Т.е. будущее не зависит от прошлого, кроме как от настоящего состояния, которое сохраняет в себе все прошлые события агента.

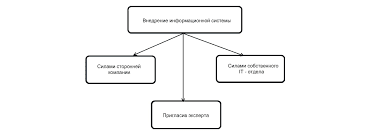

Что делает отдел по эксплуатации и сопровождению ИС? Отвечает за сохранность данных (расписания копирования, копирование и пр.)...  ЧТО ПРОИСХОДИТ, КОГДА МЫ ССОРИМСЯ Не понимая различий, существующих между мужчинами и женщинами, очень легко довести дело до ссоры...  ЧТО И КАК ПИСАЛИ О МОДЕ В ЖУРНАЛАХ НАЧАЛА XX ВЕКА Первый номер журнала «Аполлон» за 1909 г. начинался, по сути, с программного заявления редакции журнала...  Живите по правилу: МАЛО ЛИ ЧТО НА СВЕТЕ СУЩЕСТВУЕТ? Я неслучайно подчеркиваю, что место в голове ограничено, а информации вокруг много, и что ваше право... Не нашли то, что искали? Воспользуйтесь поиском гугл на сайте:

|