|

|

ДИНАМИЧЕСКОЕ ПРОГРАММИРОВАНИЕ (ДП)Методы оптимизации обучения с подкреплением можно разделить на два широких класса: на основе модели и без модели. Методы на основе моделей предполагают существование внутренней модели, параметры которой должны быть оценены. Соответствующие действия затем выбираются путем поиска или планирования в этой оценочной модели. Методы без модели используют опыт, чтобы изучать более простые величины, такие как состояние или значения действия, без оценки модели. Динамическое Программирование (ДП) – основанный на модели метод, в частности на перечислениистратегий иценности. Эти два метода перечисления могут быть использованы для надежного вычисления оптимальных стратегий и функций ценности. Оба они получаются путем чередования двух вычислений: оценки стратегии и улучшения стратегии. Оценка стратегии – вычислить функцию ценности состояния Vπ для произвольной стратегии π. Улучшение стратегии -

Мы можем сначала применить раунд оценки стратегии, который определит итеративный расчет функции ценности для текущей стратегии. Затем мы переключимся на раунд улучшения стратегии, который определит улучшенную стратегию, жадно выбирая лучшее действие в соответствии со значением функции ценности. Вышеупомянутый процесс повторяется до тех пор, пока стратегия не изменится. Приперечислении стратегий,шаг улучшения стратегии выполняется только один раз после того, как будет проведен шаг оценки стратегии. Напротив, при перечислении функций ценности между итерациями улучшения стратегии выполняется только одна оценка стратегий.

Рис 2.3: Обобщённоеперечислениестратегий. ДПпредставляеттехнику начальной самозагрузки (самовытягивание, bootstrapping), которая позволяет улучшать оценки ценности для каждого состояния на основе состояния-преемника.

МЕТОДЫМОНТЕ-КАРЛО (МКМ) Все рассмотренные до сих пор методы требуют от нас полного знания об окружающей среде, чего нет в нашем проекте. Вместо этого рассмотрим методы Монте-Карло (МКМ), которые являются методами безмодели, они позволяют агенту учиться на выбранных последовательностях состояний, действий и вознаграждений, полученных непосредственно из окружающей среды. МКМ хорошоподходят в нашемслучае, т.к. не требуют предварительных знаний о динамике окружающей среды. МКМ усредняет выборки, возвращаемые из среды эпизодами по отдельности, в отличие от ДП, где данные обновляются поэтапно. Ценностью состояния является ожидаемая выгода — ожидаемое накопленное будущее приведенное вознаграждение, — получаемая начиная с данного состояния. Тогда очевидным способом оценить выгоду, основываясь на опыте, будет простое усреднение значений выгоды, полученных после того, как было пройдено данное состояние.С ростом числа наблюдений, дающих значения выгоды, среднее значение выгоды должно сходиться к ожидаемой величине. LISTING 2.1: МКМ

Поддержание достаточной уровня исследования (exploration) является проблемой для управления при помощи МКМ. Агент должен выдерживать баланс между исследованием и эксплуатацией (exploitation), чтобы добывать информацию о наградах и об окружающей среде. Он должен исследовать, рассматривая как ранее неиспользуемые действия, так и неопределенные действия, которые могут привести к отрицательным вознаграждениям. При принятии решения свою роль играют безопасность, известность награды и риск попробовать новое, для обнаружения более высокой награды. В общем, есть два подхода, которые могут быть использованы для решения проблемы баланса – методы с интегрированной оценкой ценности стратегий (on-policy) (ИМК-метод) и методы с разделенной оценкой ценности стратегий (off-policy) (пример???в книге). Методы-on-policy пытаются оценивать или улучшать стратегию непосредственно при использовании её для принятия решений. С другой стороны, методы-off-policy пытаются обучиться детерминированной стратегии [действий], которая может быть не связана со стратегией принятия решений. Одной из распространенных форм on-policy методов являются стратегии E-greedy. Это гибкая стратегия (π (s, a)> 0, ∀s ∈ S, a ∈ A (s)), где большую часть времени выбирается действие с оценённым максимальным значением-действия, однако, с вероятностьюE всё же выбирается случайное действие.

2.1.8 ОБУЧЕНИЕПРИ ПОМОЩИ ВРЕМЕННЫХ РАЗЛИЧИЙ TD-обучениеестьобъединениеспособностиучитьсячерезсамотестирование (bootstrapping) ДП, и способности обучаться напрямую из выборки взятой из среды без кППР. В отличие от МКМ, TD-методы могут не ждать конца эпизода для обновления значений функции. Вместо этого они только ждут следующего шага по времени, используя временные ошибки чтобы информировать нас насколько отличается новое значение от предыдущего предсказания. Этообновлениеимеетобщуюформу: НоваяОценка ← СтараяОценка + РазмерШага[Цель − СтараяОценка] (2.15)

ПростейшийTD-метод, известный как TD(0), определяется так: V (st) ← V(st) + α[rt+1 + γV(st+1) − V(st)] (2.16) Его безмодельная природа является преимуществомнадДП,аполностью последовательные on-line обновления – над МКМ. Этоособенноважно, когдаработать приходитсясдолгими (возможно бесконечными) эпизодами, так что любые откладывания обновлений на конец эпизода являются нежелательными. Обсудим 2 важныхTDалгоритма управления ниже.

SARSA SARSA – это on-policy алгоритм TD управления, которыйобозначает State-Action-Reward-State-Action. Егоимяпроисходитотэксперимента (s,a,r,s`,a`), вкоторымагентначинаетвсостоянии s, выполняетдействиеa, получаетнаградуr, переходит в состояние s`, и затем решает выполнить действие a`. Этотопытиспользуетсядляобновления Q(s,a) с использованием следующего уравнения: Q(st, at) ← Q(st, at) + α[r + γQ(st+1, at+1) − Q(st, at)] (2.17)

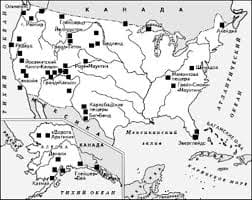

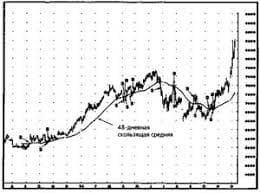

Система охраняемых территорий в США Изучение особо охраняемых природных территорий(ООПТ) США представляет особый интерес по многим причинам...  ЧТО ТАКОЕ УВЕРЕННОЕ ПОВЕДЕНИЕ В МЕЖЛИЧНОСТНЫХ ОТНОШЕНИЯХ? Исторически существует три основных модели различий, существующих между...  Что делать, если нет взаимности? А теперь спустимся с небес на землю. Приземлились? Продолжаем разговор...  Что вызывает тренды на фондовых и товарных рынках Объяснение теории грузового поезда Первые 17 лет моих рыночных исследований сводились к попыткам вычислить, когда этот... Не нашли то, что искали? Воспользуйтесь поиском гугл на сайте:

|