|

|

ПРОБУЕМ СОКРАТИТЬ ВРЕМЯ ОБУЧЕНИЯДо сих пор мы тренировали нашего агента обучением без учителя путем случайного исследования окружающей среды. В этом разделе мы экспериментируем с обучением с учителем, чтобы выяснить, можно ли использовать его для сокращения времени обучения. Мы рассматриваем использование информации изсимуляции для наблюдения агентом за учителем или оракулом O, выполняющим задачу. Требуется способ вычисления набора действий, необходимых для решения задачи.

ОБРАТНАЯ КИНЕМАТИКА Две распространенные задачи робототехники– это кинематика и обратная кинематика. Прямая кинематика решает проблему расчета положения захвата из расчёта углов сочленений. Более полезной, но более сложной является задача обратной кинематики, которая вычисляет углы сочленений исходя из желаемого положение захвата.Используя простой метод обратной кинематики, мы разрабатываем алгоритм, который занимает позицию над кубом для его захвата. Тогда мы сможем выполнить фиксированный набор действий, которые приведут к захвату куба и последующему его поднятию.

Алгоритм O-Greedy МымодифицируемсуществующийалгоритмглубокогообученияQ-learningдобавлениемгибридногоисследованияпространстваЕ-greedyиобучениясучителем.

LISTING 6.1: Наш новый алгоритмO-greedy

Чтобы оценить эффективность предложенного выше алгоритма, мы запускаем два одинаковых эксперимента – один использует E-greedy, а другой использует O-greedy. Поскольку это не основная цель этой работы, мы решили запустить меньшую сеть, которая не принимает изображения, но вместо этого работает только с совместными углами. Свёрточная сеть, используемая в наших экспериментах до сих пор, заменена 2х-слойной полносвязной сетью с 7 входами, соответствующими шести углам сочленений и состоянию захвата. Сокращение общее времени итерации, используем постоянные положение цели и значения углов в начале каждого эпизода. Сначала мы покажем результаты запусков E-Greedy.

Рис.6.18: Результаты запусков Е-greedy для полносвязной сети. Большее число эпизодовтребуется для начала получения стабильных успехов (рис.6.18а) в сравнении с нашей свёрточной сетью из раздела 6.3. Интересно, примерно с эпизода 3000 наблюдаем длительный период безуспешных попыток после серии успешных. Более того, на рисунках 6.18c и 6.18d видим падения среднего вознаграждения и среднихQ-значений, что свидетельствует о временной потере навыков. Затем агент некоторое время переучиваетчто-то, что он уже узнал, что демонстрируетуверенныйростQ-значений. Несмотря на большее количество эпизодов по сравнению с разделом 6.3, время работы было намного меньше из-за меньшего времени обучения нейросети и из-за отсутствия необходимости в изображениях симуляции. Вероятно, большее число эпизодов связано с отсутствием визуальной обратной связи в случаях, когда агент случайно сбивал куб. Будто бы агент начинал изучать, какие именно углы сочленений дали наибольшую награду, но потом изредка сбивал куб, что могло вызвать колебания в наградах, а это в свою очередь могло смутить агента. Теперь мы повторим эксперимент выше с методом O-greedy.

Рис.6.19: Результаты запуска O-greedy с простой полносвязной сетью. При оценке результатов этого эксперимента нельзя отслеживать прогресс в отдельности, как в других экспериментах, потому что агент будет очень частосправляться, следуя оракулу. Поэтому отслеживаем общее количество успехов (рис. 6.19a), а также количество успехов, исключая те эпизоды, в которых мы следовали оракулу (рис. 6.19b). На первый взгляд, результаты выглядят так, будто для достижения успеха требуется больше времени, чем в предыдущем эксперименте, но обратите внимание на эпсилон на рисунке 6.19c по сравнению с рисунком 6.19b– существует очень небольшая задержка между тем, когда эпсилон достигает своего постоянного значения, и первым потоком успехов, по сравнениюс предыдущим экспериментом. Хотя эпизод, в котором агент выучил стратегию, происходит позже, чем в предыдущем эксперименте, более короткая задержка говорит нам, что на самом деле этот метод быстрее, чем предыдущий. Причина большего количества эпизодов объясняется тем, что больше эпизодов завершается по сравнению с предыдущим экспериментом.Количество раз (=ε), когда мы следуем за оракулом, которыйзавершает эпизод за гораздо меньше итераций, чем верхний предел в 1000 итераций, установленных на эпизод.Оглядываясь назад, было бы яснее измерять прогресс в итерациях, а не в эпизодах для обоих этих экспериментов. Средние Q-значения на рисунке 6.19e ведут себя так, как мы и ожидали. Во время больших значений эпсилон мы с большей вероятностью следуем за оракулом, и при этом часто получаем высокую награду, вызывающую переоценку Q-значений в каждом из состояний. Только когда эпсилон уменьшается и позволяет проводить более случайные исследования состояний, тогда значения падают до более реалистичных величин. Мы полагаем, что сравнение этих двух экспериментов ясно показывает более быстрое обучение при использовании O-greedy. К сожалению, из-за нехватки времени мы не смогли продолжить эту работу.

СРАВНЕНИЕАГЕНТОВ До сих пор мы тренировали несколько агентов в разных сценариях. Теперь мы возьмем некоторых из этих агентов и протестируем их работу на обученном сценарии, а также на сценариях, для которых они не были обучены. Агенты: • Агент A. Фиксированные начальные положение куба и углы сочленений. • Агент B. То же, что и агент A, но добавлены входы конфигурации робота. • Агент C. Вариации положений куба и углов сочленений. Мы применяем каждый из вышеперечисленных агентов к рассмотренным двум сценариям: статическое положение куба, перемещение куба с изменениями конфигурации робота в начале эпизодов. Каждый тест проводился до успешных 50 эпизодов, когда агент поднимал куб до заданной высоты.

Табл.6.1: Показатели успеха агентов, Выделенные ячейки показывают долю успешных попыток агента, когда он тестировался в той же ситуации, на которой был обучен. Все агенты хорошо справляются с обученными сценариями – проходили не менее чем в 50% случаев. Ожидаем увеличение успехов при более продолжительных тренировках. Можно видеть, что агенты A и B плохо работают в ситуации B, поскольку агент не ожидал обобщения на другие исходные состояния. Агент С хорошо справился с ситуацией А. Агенты, обученные с вариациями, могут хорошо адаптироваться и к ситуациям с небольшими вариациями или без них.

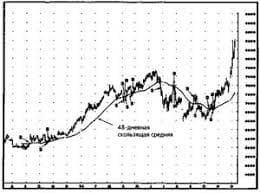

Что будет с Землей, если ось ее сместится на 6666 км? Что будет с Землей? - задался я вопросом...  ЧТО ПРОИСХОДИТ ВО ВЗРОСЛОЙ ЖИЗНИ? Если вы все еще «неправильно» связаны с матерью, вы избегаете отделения и независимого взрослого существования...  ЧТО ТАКОЕ УВЕРЕННОЕ ПОВЕДЕНИЕ В МЕЖЛИЧНОСТНЫХ ОТНОШЕНИЯХ? Исторически существует три основных модели различий, существующих между...  Что вызывает тренды на фондовых и товарных рынках Объяснение теории грузового поезда Первые 17 лет моих рыночных исследований сводились к попыткам вычислить, когда этот... Не нашли то, что искали? Воспользуйтесь поиском гугл на сайте:

|