|

|

Т.е. количество информации, приобретаемое при полном выяснении состоянии некоторой физической системы, равно энтропии этой системы.Учитывая (1.1), при а=2, получим Ix= – где pi = P(X ~ xi) Формула (1.5) означает, что информация Ix есть осредненное по всем состояниям системы значение логарифма вероятности состояния с обратным знаком. Действительно, для получения Ix каждое значение

Тогда информация Ixпредставится как средняя (или полная) информация, получаемая от всех возможных отдельных сообщений с учетом их вероятностей. Если все возможные состояния системы одинаково вероятны (p1=p2=…=pn=1/n), то формула (1.5) может быть преобразована к виду: Ix=log2n Если информация выражена в двоичных единицах, то ей можно дать довольно наглядное истолкование, а именно: измеряя информацию в двоичных единицах, мы условно характеризуем ее числом ответов «да» или «нет», с помощью которых можно приобрести ту же информацию. Сообщение, уменьшающее неопределенность знаний человека в два раза несет для него один бит информации. Рассмотрим систему с двумя состояниями:

Чтобы выяснить состояние этой системы, достаточно задать один вопрос: находится ли система в состоянии х1? Ответ «да» или «нет» доставляет некоторую информацию, которая достигает своего максимального значения 1, когда оба состояния равновероятны: p1=p2=1/2, т.о. максимальная информация, даваемая ответом «да» или «нет», равна одной двоичной единице. Если информация от какого-то сообщения равна n двоичным единицам, то она равносильна информации, даваемыми n ответами «да» или «нет» на вопросы, поставленные так, что «да» и «нет» одинаково вероятны. Если поставить вопросы так не удается, можно утверждать только, что минимальное число вопросов, необходимых для выяснения содержания данного сообщения, не меньше, чем информация, заключенная в сообщении. Пример. Некто задумал любое целое число Х от единицы до восьми 1 ≤ Х ≤ 8, а нам предлагается угадать его, поставив минимальное число вопросов на каждый из которых дается ответ «да» или «нет». Решение: Определяем информацию, заключенную в сообщении, какое число задумано. Априори все значения Х от 1 до 8 одинаково вероятны:

Минимальное число вопросов, которые нужно поставить для выяснения задуманного числа, не меньше трех. В данном случае можно, действительно, обойтись тремя вопросами, если сформулировать их так, чтобы вероятности ответов «да» или «нет» были равны. Пусть, например, задумано число «пять», мы этого не знаем и задаем вопросы: Вопрос 1. Число Х меньше пяти? Ответ: Нет. Вопрос 2. Число Х меньше семи? Ответ: Да. Вопрос 3. Число Х меньше шести? Ответ: Да. Легко убедиться, что тремя такими (или аналогичными) вопросами можно установить любое задуманное число от 1 до 8) Информация и алфавит Алфавитный подход к измерению информации позволяет определить количество информации, заключенной в тексте. Алфавитный подход является объективным, т. е. он не зависит от субъекта (человека), воспринимающего текст. Множество символов, используемых при записи текста, называется алфавитом. Полное количество символов в алфавите называется мощностью (размером) алфавита. Если допустить, что все символы алфавита встречаются в тексте с одинаковой частотой (равновероятно), то количество информации, которое несет каждый символ, вычисляется по формуле: x = log2N, (т. к. N = 2х), где N – мощность алфавита. Следовательно, в 2-символьном алфавите каждый символ «весит» 1 бит (log22 = 1); в 4-символьном алфавите каждый символ несет 2 бита информации (log24 = 2); в 8-символьном – 3 бита (log28 = 3) и т. д. один символ из алфавита мощностью 256 (28) несет в тексте 8 бит информации. Такое количество информации называется байт. Алфавит из 256 символов используется для представления текстов в компьютере. 1 байт = 8 бит. Если весь текст состоит из К символов, то при алфавитном подходе размер содержащейся в нем информации равен: V = K x, где x – информационный вес одного символа в используемом алфавите. Для измерения информации используются и более крупные единицы: 1 Кбайт (килобайт) = 210 байт = 1024 байта 1 Мбайт (мегабайт) = 220 байт = 1024 Кбайта 1 Гбайт (гигабайт) = 230 байт = 1024 Мбайта 1 Тбайт (терабайт) = 240 байт = 1024 Гбайта

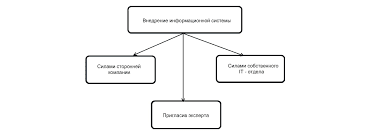

пример 4 книга, набранная с помощью компьютера, содержит 150 страниц; на каждой странице – 40 строк, в каждой строке – 60 символов. Каков объем информации в книге? Решение. Мощность компьютерного алфавита равна 256. один символ несет 1 байт информации. Значит, страница содержит 40 х 60 = 2400 байт информации. Объем информации в книге (в разных единицах): 2400 х 150 = 3600 байт. 360000/1024 = 351,5625 Кбайт. 351,5625/1024 = 0,34332275 Мбайт. Системы счисления   ЧТО ТАКОЕ УВЕРЕННОЕ ПОВЕДЕНИЕ В МЕЖЛИЧНОСТНЫХ ОТНОШЕНИЯХ? Исторически существует три основных модели различий, существующих между...  Что будет с Землей, если ось ее сместится на 6666 км? Что будет с Землей? - задался я вопросом...  Живите по правилу: МАЛО ЛИ ЧТО НА СВЕТЕ СУЩЕСТВУЕТ? Я неслучайно подчеркиваю, что место в голове ограничено, а информации вокруг много, и что ваше право...  Что делает отдел по эксплуатации и сопровождению ИС? Отвечает за сохранность данных (расписания копирования, копирование и пр.)... Не нашли то, что искали? Воспользуйтесь поиском гугл на сайте:

|