|

|

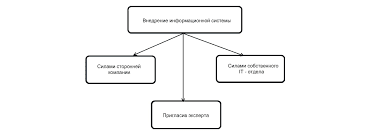

Проблема искусственного интеллекта в свете новейших достижений кибернетики и информатики. Спектр подходовУчение об искусственном интеллекте — разработка интеллектуальных машин и систем, особенно интеллектуальных компьютерных программ, направленных на то, чтобы понять человеческий интеллект. При этом используемые методы не обязаны быть биологически правдоподобны. Но проблема состоит в том, что неизвестно какие вычислительные процедуры мы хотим называть интеллектуальными. А так как мы понимаем только некоторые механизмы интеллекта, то под интеллектом в пределах этой науки мы понимаем только вычислительную часть способности достигнуть целей в мире. Но до сих пор единого ответа на вопрос чем занимается искусственный интеллект, не существует. Почти каждый автор, пишущий книгу об ИИ, отталкивается в ней от какого-либо определения, рассматривая в его свете достижения этой науки. Обычно эти определения сводятся к следующим: Тест Тьюринга. Тест Тьюринга — эмпирический тест, идея которого была предложена Аланом Тьюрингом в статье «Вычислительные машины и разум» (англ. Computing Machinery and Intelligence), опубликованной в 1950 году в философском журнале «Mind». Тьюринг задался целью определить, может ли машина мыслить. Стандартная интерпретация этого теста звучит следующим образом: «Человек взаимодействует с одним компьютером и одним человеком. На основании ответов на вопросы он должен определить, с кем он разговаривает: с человеком или компьютерной программой. Задача компьютерной программы — ввести человека в заблуждение, заставив сделать неверный выбор». Все участники теста не видят друг друга. Если судья не может сказать определенно, кто из собеседников является человеком, то считается, что машина прошла тест. Чтобы протестировать именно интеллект машины, а не её возможность распознавать устную речь, беседа ведется в режиме «только текст», например, с помощью клавиатуры и экрана (компьютера-посредника). Переписка должна производиться через контролируемые промежутки времени, чтобы судья не мог делать заключения исходя из скорости ответов. Во времена Тьюринга компьютеры реагировали медленнее человека. Сейчас это правило необходимо, потому что они реагируют гораздо быстрее, чем человек. По состоянию на 2009 год ни одна из существующих компьютерных систем не приблизилась к прохождению теста. Логический подход. Логический подход к созданию систем искусственного интеллекта направлен на создание экспертных систем с логическими моделями баз знаний с использованием языка предикатов. Учебной моделью систем искусственного интеллекта в 1980-х годах был принят язык и система логического программирования Пролог. Логическая модель баз знаний позволяет записывать не только конкретные сведения и данные в форме фактов на языке Пролог, но и обобщенные сведения с помощью правил и процедур логического вывода и в том числе логических правил определения понятий, выражающих определенные знания как конкретные и обобщенные сведения. В целом исследования проблем искусственный интеллект в информатике в рамках логического подхода к проектированию баз знаний и экспертных систем направлено на создание, развитие и эксплуатацию интеллектуальных информационных систем, включая вопросы обучения студентов и школьников, а также подготовки пользователей и разработчиков таких интелектуальных информационных систем. Агентно-ориентированный подход. Последний подход, развиваемый с начала 1990-х годов называется агентно-ориентированным подходом, или подходом, основанным на использовании интеллектуальных (рациональных) агентов. Согласно этому подходу, интеллект — это вычислительная часть (грубо говоря, планирование) способности достигать поставленных перед интеллектуальной машиной целей. Сама такая машина будет интеллектуальным агентом, воспринимающим окружающий его мир с помощью датчиков и способной воздействовать на объекты в окружающей среде с помощью исполнительных механизмов. Этот подход акцентирует внимание на тех методах и алгоритмах, которые помогут интеллектуальному агенту выживать в окружающей среде при выполнении его задачи. Так, здесь значительно сильнее изучаются Алгоритмы поиска и принятия решений. Другие подходы Интуитивные. Самый общий подход предполагает, что ИИ будет способен проявлять поведение, не отличающееся от человеческого, причём, в нормальных ситуациях. Эта идея является обобщением подхода теста Тьюринга, который утверждает, что машина станет разумной тогда, когда будет способна поддерживать разговор с обычным человеком, и тот не сможет понять, что говорит с машиной (разговор идёт по переписке). Писатели-фантасты часто предлагают ещё один подход: ИИ возникнет тогда, когда машина будет способна чувствовать и творить. Так, хозяин Эндрю Мартина из «Двухсотлетнего человека» начинает относиться к нему как к человеку, когда тот создаёт игрушку по собственному проекту. А Дейта из Звёздного пути, будучи способным к коммуникации и научению, мечтает обрести эмоции и интуицию. Первые упоминания Хотя исследования в области искусственного интеллекта начались в 1956 году, их философские корни уходят глубоко в прошлое. Вопрос, может машина думать или нет, имеет долгую историю. Он тесно связан с различиями между дуалистическим и материалистическим взглядами. С точки зрения дуализма, мысль не является материальной (или, по крайней мере, не имеет материальных свойств), и поэтому разум нельзя объяснить только с помощью физических понятий. С другой стороны, материализм гласит, что разум можно объяснить физически, таким образом, оставляя возможность существования разумов, созданных искусственно. В 1936 году философ Альфред Айер рассмотрел обычный для философии вопрос касательно других разумов: как узнать, что другие люди имеют тот же сознательный опыт, что и мы? В своей книге «Язык, истина и логика» Айер предложил алгоритм распознавания сознающего человека и не осознающей машины: «Единственным основанием, на котором я могу утверждать, что объект, который кажется разумным, на самом деле не разумное существо, а просто глупая машина, является то, что он не может пройти один из эмпирических тестов, согласно которым определяется наличие или отсутствие сознания». Это высказывание очень похоже на тест Тьюринга, однако точно неизвестно была ли известна Тьюрингу популярная философская классика Айера. Что касается прикладных наук, «робототехника» было впервые использовано в печати Айзеком Азимовым в научно-фантастическом рассказе «Лжец», опубликованном в 1941 г. «Робототехника» базируется на слове «робот», придуманном в 1920 г. научным фантастом и Нобелевским лауреатом Карлом Чапеком для своей пьесы Р. У.Р. (Россумские Универсальные Роботы, чеш. Rossumovi univerzální roboti). Слово «робот» происходит от чешского слово «robota», означающего «крепостной труд» или, образно, «тяжелая работа». Однако, интерес к идеям, схожим с робототехникой, наблюдался еще до введения этого термина, в 8-7 вв до н. э. В «Илиаде» бог Гефест сделал говорящих служанок из золота. Архиту Тарентскому приписывают создание механического голубя в 400 г. до н. э. Роботы используются в промышленных, военных, прикладных и научно-исследовательских целях. Философские проблемы Философия искусственного интеллекта задаётся вопросами о «мышлении машин», рассматривает вопросы: -Может ли машина действовать разумно? Может ли она решать проблемы, которые человек решает с помощью размышлений? -Может ли машина иметь разум, сознание, психическое состояние в той мере, в которой ими обладает человек. Может ли она чувствовать? -Одинакова ли природа человеческого и искусственного интеллекта? Является ли в своей основе человеческий мозг компьютером? Эти вопросы отражают интересы различных исследователей искусственного интеллекта, философов, исследователей познавательной (когнитивной) деятельности. Ответы на эти вопросы зависят от того, что понимается под понятиями «интеллект» или «сознания», и какие именно «машины» являются предметом обсуждения. Наиболее горячие споры в философии искусственного интеллекта вызывает вопрос возможности мышления творения человеческих рук. Вопрос «Может ли машина мыслить?», который подтолкнул исследователей к созданию науки о моделировании человеческого разума, был поставлен Аланом Тьюрингом в 1950 году. Две основных точки зрения на этот вопрос носят названия гипотез сильного и слабого искусственного интеллекта. Термин «сильный искусственный интеллект» ввел Джон Сёрль, его же словами подход и характеризуется. Более того, такая программа будет не просто моделью разума; она в буквальном смысле слова сама и будет разумом, в том же смысле, в котором человеческий разум — это разум. Напротив, сторонники слабого ИИ предпочитают рассматривать программы лишь как инструмент, позволяющий решать те или иные задачи, которые не требуют полного спектра человеческих познавательных способностей.В своем мысленном эксперименте «Китайская комната», Джон Сёрль показывает, что прохождение теста Тьюринга не является критерием наличия у машины подлинного процесса мышления.Мышление есть процесс обработки находящейся в памяти информации: анализ, синтез и самопрограммирование. Аналогичную позицию занимает и Роджер Пенроуз, который в своей книге «Новый ум короля» аргументирует невозможность получения процесса мышления на основе формальных систем. Также философии пришлось столкнуться с этические проблемы создания искусственного разума. Рассмотрим некоторые проблемы, которые могут возникнуть при и после создания ИИ. Следует отметить, что в данном реферате изложен далеко не полный перечень таких проблем. Проблема 1. Проблема безопасности. Данная проблема будоражит умы человечества еще со времен Карела Чапека, впервые употребившего термин "робот". Большую лепту в обсуждение данной проблемы внесли и другие писатели-фантасты. Как самые известные можно упомянуть серии рассказов писателя-фантаста и ученого Айзека Азимова, а так же довольно свежее произведение — "Терминатор". Кстати, именно у Айзека Азимова можно найти самое проработанное, и принятое большинством людей решение проблемы безопасности – трех законах роботехники: · Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред. · Робот должен повиноваться командам, которые ему дает человек, кроме тех случаев, когда эти команды противоречат первому закону. · Робот должен заботиться о своей безопасности, насколько это не противоречит первому и второму закону. На первый взгляд подобные законы, при их полном соблюдении, должны обеспечить безопасность человечества. Однако при внимательном рассмотрении возникают некоторые вопросы. Во-первых, законы сформулированы на человеческом языке, который не допускает простого их перевода в алгоритмическую форму. К примеру: как перевести на любой из известных языков программирования, такой термин, как "причинить вред". Или "допустить". Попробуйте определить, что происходит в любом случае, а что он "допустил"? Далее предположим, что мы сумели переформулировать, данные законы на язык, который понимает автоматизированная система. Теперь интересно, что будет подразумевать система ИИ под термином "вред" после долгих логических размышлений? Не решит ли она, что все существования человека это сплошной вред? Ведь он курит, пьет, с годами стареет и теряет здоровье, страдает. Не будет ли меньшим злом быстро прекратить эту цепь страданий? Конечно можно ввести некоторые дополнения, связанные с ценностью жизни, свободой волеизъявления. Но это уже будут не те простые три закона, которые были в исходнике. Следующим вопросом будет такой. Что решит система ИИ в ситуации, когда спасение одной жизни возможно только за счет другой? Особенно интересны те случаи, когда система не имеет полной информации о том, кто есть кто. Несмотря на перечисленные проблемы, данные законы являются довольно неплохим неформальным базисом проверки надежности системы безопасности для систем ИИ. Так что же, неужели нет надежной системы безопасности? Если отталкиваться от концепции ИИ, то можно предложить следующий вариант. Согласно многочисленным опытам, несмотря на то, что мы не знаем точно, за что отвечает каждый отдельный нейрон в человеческом мозге, многим из наших эмоций обычно соответствует возбуждение группы нейронов (нейронный ансамбль) во вполне предсказуемой области. Были также проведены обратные эксперименты, когда раздражение определенной области вызывало желаемый результат. Это могли быть эмоции радости, угнетения, страха, агрессивности. Это наводит на мысль, что в принципе мы вполне могли бы вывести степень "довольности" организма наружу. В то же время, практически все известные механизмы адаптации и самонастройки (в первую очередь имеются в виду технические системы), базируются на принципах типа "хорошо" — "плохо". В математической интерпретации это сведение какой-либо функции к максимуму или к минимуму. Теперь представим себе, что ИИ в качестве такой функции использует измеренную прямо или косвенно, степень удовольствия мозга человека-хозяина. Если принять меры, чтобы исключить самодеструктивную деятельность в состоянии депрессии, а так же предусмотреть другие особые состояния психики, то можно получить вполне стабильную систему. Вывод по проблеме 1. Поскольку предполагается, что нормальный человек, не будет наносить вред самому себе, и, без особой на то причины, другим, а ИИ теперь является частью данного индивидуума (не обязательно физическая общность), то автоматически выполняются все 3 закона роботехники. При этом вопросы безопасности смещаются в область психологии и правоохранения, поскольку система (обученная) не будет делать ничего такого, чего бы не хотел ее владелец.   ЧТО ПРОИСХОДИТ, КОГДА МЫ ССОРИМСЯ Не понимая различий, существующих между мужчинами и женщинами, очень легко довести дело до ссоры...  Живите по правилу: МАЛО ЛИ ЧТО НА СВЕТЕ СУЩЕСТВУЕТ? Я неслучайно подчеркиваю, что место в голове ограничено, а информации вокруг много, и что ваше право...  ЧТО ТАКОЕ УВЕРЕННОЕ ПОВЕДЕНИЕ В МЕЖЛИЧНОСТНЫХ ОТНОШЕНИЯХ? Исторически существует три основных модели различий, существующих между...  Что делает отдел по эксплуатации и сопровождению ИС? Отвечает за сохранность данных (расписания копирования, копирование и пр.)... Не нашли то, что искали? Воспользуйтесь поиском гугл на сайте:

|