|

|

Часть iii. многомерные методы и модели

между 10 объектами, в каждой из которых по 3 ложных нулевых значения. К таким данным применима модель МШ индивидуальных различий. Результаты обработки (программа 8Р88) приведены в табл. 18.3. 10 верхних строк этой таблицы — координаты объектов в двух шкалах, а две нижние строки — индивидуальные веса шкал. Величина индивидуального веса по соответствующей шкале показывает, насколько учитывается признак при различении объектов. Как и следовало ожидать, каждый наблюдатель учитывает только одну координату — точку зрения на объекты, игнорируя другую. Тем не менее, двух точек зрения

2,00 1,50 1,00 0,50 0,00 -0,50 -1,00 -1,50 -2,00 Метрические отношения между объектами не удалось воспроизвести точ- но в связи с малым числом наблюдателей. Если бы был третий наблюдатель, точка зрения которого отличалась от первых двух, то восстановились бы и метрические отношения. Если эксперты не оценивают различия, а упорядочивают объекты по степени предпочтения, то применяется модель предпочтения. Исходными данными для МШ предпочтений является матрица размером ИхР, где N строк соответствуют экспертам, а Р — это столбцы, содержащие ранговые места предпочтений объектов экспертами. В дистанционной модели предпочтений каждый эксперт характеризуется координатами своей идеальной точки в пространстве /^признаков. Эти координаты — такая комбинация характеристик объектов, которую эксперт считает идеальной. Результирующая матрица содержит, помимо координат объектов, и координаты идеальных точек — по одной для каждого эксперта. Для нашего примера эксперты могли бы упорядочивать объекты по степени их наблюдаемой близости. Таким образом, описание объектов, полученное от каждого наблюдателя, стало бы экономнее. Результатом применения модели предпочтения была бы конфигурация объектов и «идеальных точек» наблюдателей, расположенных вблизи тех объектов, которые оказались рядом с наблюдателями. Итак, МШ в своих основных трех модификациях позволяет решать три группы задач: 1. Исходные данные — прямые оценки субъектом различий между стимулами или вычисленные расстояния между объектами, характеризующимися совокупностью признаков. Примером второго типа данных могут являться расстояния между ролями (объектами), вычисленные по совокупности конструктов (репертуарные решетки Келли). МШ позволяет реконструировать психологическое пространство субъекта, как конфигурацию стимулов в осях существенных признаков, по которым эти стимулы различаются субъектом. 2. Исходные данные — те же, что и в предыдущем случае субъективные различия между стимулами (оцененные прямо или вычисленные), но полученные не от одного, а от группы субъектов. Взвешенная модель индивидуальных различий позволяет получить групповое психологическое пространство стимулов в осях общих для данной группы существенных признаков. Дополнительно к этому для каждого субъекта — индивидуальные веса признаков как меру учета соответствующих точек зрения при различении стимулов. 3. Исходные данные — результаты упорядочивания каждым из группы субъектов набора стимулов по степени предпочтения. Модель анализа предпочтений позволяет получить групповое психологическое пространство стимулов в осях существенных признаков и размещенные в этом же пространстве идеальные точки для каждого субъекта. МЕРЫ РАЗЛИЧИЯ Непосредственными данными для многомерного шкалирования является информация о различиях между объектами. Эти различия должны быть определены между всеми парами объектов и иметь числовое выражение. Первое требование означает, что анализируется матрица попарных различий УУхА^ (где N — количество изучаемых объектов). Второе условие требует измерения различия, то есть введения метрики. Существуют четыре стандартных критерия, которым должна удовлетворять мера различия, чтобы быть метрикой: 1. Симметрия. Даны два объекта: х и у. Расстояние от х до у должно быть равно расстоянию от у до х. 2. Неразличимость идентичных объектов. Расстояние между двумя идентичными объектами равно 0. 3. Различимость нетождественных объектов. Расстояние между двумя различающимися объектами не равно 0. 4. Неравенство треугольника. Даны три объекта: х, у и г. Расстояние от х до у меньше или равно сумме расстояний от х до г и от г до у (длина любой стороны треугольника меньше или равна сумме двух других сторон). Эти очевидные требования, однако, не всегда выполняются в отношении некоторых показателей различия. Например, в случае социальных взаимных предпочтений: Петру нравится Маша, но Маше Петр не нравится. В этом случае симметрия не соблюдена, показатель не может быть метрикой, и такие данные должны быть преобразованы к симметричному виду (разумеется, с потерей информации об асимметрии). Из критерия симметрии следует, что матрица попарных различий./Ух ТУ является симметричной относительно главной диагонали. Из критерия неразличимости идентичных объектов следует, что на главной диагонали этой матрицы различий расположены нули. Выбор меры различия является органической частью исследования, определяется его процедурой и характером получаемых данных. По процедуре исследования можно выделить три типичные ситуации: испытуемые непосредственно оценивают степень различия (близости) изучаемых объектов; имеются данные об условной или совместной встречаемости событий (объектов); имеется совокупность оценок для множества объектов — используются меры различия профилей оценок. Отметим, что для МШ чаще всего используют непосредственные оценки различий. Остальные меры различий более специфичны для кластерного анализа. Непосредственная оценка различий Существует большое количество достаточно хорошо разработанных процедур субъективной оценки различия между объектами: это и прямая оценка различия пары объектов при помощи заданной шкалы (от 5 до 10 градаций) или графически, и сортировка пар по категориям различия (от идентичных до максимально различных). Основная сложность этих процедур — большое количество пар объектов, предлагаемых испытуемым для сравнения. Для N объектов должно быть оценено количество пар, равное N(N-1)/2. Например, если объектов 20, испытуемый должен оценить различия 190 пар объектов. Самый простой способ организации предъявления всех возможных пар объектов — табличный ТУх^У, когда испытуемый, оценивая различия, заполняет нижний (верхний) треугольник таблицы. Однако при таком предъявлении на оценку различий между объектами влияют не только сами стимулы, но и порядок их предъявления. Речь идет о так называемых пространственных и временных искажениях. Пространственные искажения — это влияние порядка следования объектов в каждой паре (второй объект в паре воспринимается иначе, чем первый). Временные искажения — это влияние порядка следования пар (пары в начале предъявления воспринимаются иначе, чем в конце ряда). Эти искажения могут быть компенсированы путем случайного упорядочивания порядка следования как объектов в паре, так и самих пар. При большом числе объектов можно воспользоваться неполным планом, когда каждая пара оценивается не всеми испытуемыми. В неполных планах пары делятся на подмножества, и каждый испытуемый оценивает пары только в одном подмножестве. Каждое из подмножеств оценивается одинаковым числом испытуемых. При непосредственной оценке различий сложных объектов, например, художественных произведений, людей и т. д., следует иметь в виду принципиальную многомерность таких объектов. Это может иметь своим следствием выделение таких тривиальных критериев-шкал, как рост или пол для людей, толщина или формат для книги и пр. Чтобы избежать таких ситуаций, целесообразно ограничивать контекст сравнения в соответствии с целями исследования — при помощи инструкции или процедуры предъявления пар для сравнения. ПРИМЕР_________________________________________________________________________ В исследовании восприятия студентами учебных курсов, проведенном С. Лященко под нашим руководством', студентам предъявлялись пары этих курсов для сравнения. Для ограничения контекста сравнения в инструкции студентам предлагалось представить себе учебный курс, который бы по содержанию во всех отношениях их устраивал («идеал»). Перед сравнением каждой пары объектов каждому испытуемому предлагалось отметить тот из них, который ближе к «идеалу». Ограничение контекста позволило исключить такие тривиальные основания сравнения, как, например, пол преподавателя (именно такой критерий оказался главным на предшествующем этапе исследования, которое проводилось без ограничения контекста сравнения). Результаты социометрии — матрицу взаимоотношений — тоже допустимо рассматривать как вариант прямой оценки различия. Ясно, что такие матрицы — несимметричные, следовательно, получаемые данные требуют предварительной оцифровки и приведения к симметричному виду. Предложенный нами подход продемонстрирован на примере обработки данных социометрии в конце главы 19. Условные и совместные вероятности Условные вероятности применяются в исследованиях, где в качестве меры различия объектов (стимулов, событий) л: и у выступает вероятность того, что объект х не встречается при наличии объекта у. Типичные исследования подобного рода — эксперименты по узнаванию и эксперименты по переходу. В первом случае исследователь предъявляет ТУ стимулов и просит испытуемого каждый раз назвать, какой из N шу был предъявлен. Эксперимент повторяется многократно. По результатам исследования заполняется таблица ТУхУУ, строки которой — стимулы, столбцы — ответы. В случае совпадения стимула и ответа к содержимому соответствующей ячейки прибавляется 0, в противном случае — 1. Затем содержимое каждой ячейки делится на количество экспериментов. При таком анализе предполагается, что чем более похожи стимулы, тем чаще они будут путаться. Такие матрицы несимметричны, но приводятся к симметричному виду путем сложения строк и столбцов с одинаковыми номерами. Иначе говоря, исходная матрица складывается с транспонированной. Аналогичным образом обрабатываются данные в экспериментах по переходу. Строки в матрице УУхЛ^при этом — состояния в начале процесса, столбцы — при окончании (например, профессиональная ориентация до обучения и после). Предполагается, что чем ближе состояния, тем чаще будет переход из одного состояния в другое. Меры различия профилей для количественных переменных Профиль — это набор оценок (количественных признаков) объекта. Если объекты — это испытуемые, то профилем могут быть их оценки по каким- либо тестам. Сравниваемыми объектами могут быть и сами признаки, и объекты, оцениваемые испытуемыми, например, по степени предпочтения. Тогда профилем будет совокупность индивидуальных значений соответственно для признака или оцениваемого объекта. Таким образом, меры различия профилей могут применяться к наиболее типичным психологическим данным — типа «объект-признак». Меры взаимосвязи — самые распространенные и очевидные показатели различия в социальных науках, в том числе в психологии. Иногда, например, в программе 8ТАТ18Т1СА, в качестве меры различия используется величина 1 - г (где г — коэффициент корреляции Пирсона). Чем более сходна форма профилей оценок для двух объектов или чем более согласованы изменения индивидуальных оценок для двух признаков, тем более они похожи (выше коэффициент корреляции), а указанная мера различия — ближе к нулю. Следует отметить важную особенность использования коэффициента корреляции в качестве меры различия. Если существует сильная взаимосвязь двух признаков, но она отрицательна (отрицательный коэффициент корреляции), то при анализе эти признаки будут трактоваться как сильно различающиеся. Но если поменять знак одной из переменных, они станут очень близки. Таким образом, коэффициенты корреляции могут являться адекватной мерой различия (близости) только в том случае, если все они положительны (или взяты по абсолютной величине — без учета знака). Меры расстояния — наиболее специфичные показатели различия именно для профилей, то есть множества ^признаков, измеренных для каждого объекта. Различие между двумя объектами, выраженное мерой расстояния, показывает, насколько в среднем различаются совокупности оценок для двух объектов, или насколько в среднем удалены друг от друга профили оценок. Другая трактовка меры расстояния — геометрическая. Это расстояние между двумя точками (объектами) в пространстве, размерность которого равна числу признаков. Значения признаков для объекта трактуются как координаты, задающие его положение в этом пространстве. Есть два способа задания расстояний, и выбор способа зависит от задачи исследования. Обычно исследователь имеет таблицу (матрицу) данных NхР, где N — строки (испытуемые, объекты), Р — столбцы (признаки, оцениваемые объекты). Если исследователя интересуют различия между объектами или испытуемыми (с точки зрения, например, их классификации), то ему необходимо задавать меры различия (расстояния) между строками. Если же ему важны основания классификации признаков, то выбираются меры различия (расстояния) между столбцами. Существует множество мер расстояния, но наиболее часто используются две: евклидово (или его квадрат) и «метрика города». Евклидово расстояние легко представить себе как кратчайшее расстояние (по прямой) между двумя точками (объектами) в пространстве двух, трех и более координат — в соответствии с числом признаков. Наиболее подходит эта метрика для метрических данных (в шкале интервалов или отношений). Если число признаков Р, то евклидово расстояние между объектами с номерами / и у выражается формулой: _р=1 где х1р\\ х]р — значения признака р для объектов с номерами / и у соответственно. В пространственном представлении эти значения трактуются как координаты объектов / и у по оси р. «Метрика города» (синонимы — «Манхаттан», «городских кварталов» или сИу-Ыоск) — получила свое название по аналогии с длиной пути пешехода, р Важное замечание относительно мер расстояния касается разного масштаба оценок (переменных). Если переменные представлены в разных шкалах, имеют разный масштаб (средние и стандартные отклонения о), то на расстояние больше будут влиять переменные, имеющие больший разброс (дисперсию). Чтобы уравнять влияние переменных на расстояние между объектами, целесообразно до вычисления расстояний нормировать переменные (делить на стандартное отклонение) или преобразовать их в г-оценки. Заключая обзор мер различия, следует отметить одно обстоятельство. Наиболее частый вид данных в психологии — это множество признаков, измеренных у множества испытуемых. И наиболее вероятно, что исследователь предпочтет, выбирая многомерное шкалирование или кластерный анализ, опираться на меры различия профилей. В этой ситуации исследователь должен отдавать себе отчет в том, что получаемые показатели различия между объектами не несут никакой иной информации, кроме констатации того, что субъект Л по измеренным признакам более похож на субъекта В, чем на субъекта С. А информация о том, по каким признакам различия больше, а по каким — меньше, утрачивается при вычислении расстояний. Таким образом, одни и те же значения различий между парами объектов могут быть обусловлены разницей в значениях по разным признакам. Это обстоятельство сильно затрудняет интерпретацию мер расстояния. Иначе дело обстоит, если меры различия профилей используются в отношении данных о субъективных предпочтениях, когда вычисляются меры различия между объектами предпочтения по множеству субъективных оценок (между столбцами — оцениваемыми объектами). Здесь интерпретация достаточно очевидна: объекты будут тем ближе, чем ближе в среднем их располагают субъекты при упорядочивании по степени предпочтения. Вообще говоря, если у исследователя есть выбор при планировании инструментария, для классификации объектов следует предпочесть непосредственные оценки различия, данные о предпочтениях или условные и совместные вероятности. Меры различия профилей для номинативных переменных

Меры различия для частот — применяются в отношении данных типа «объект-признак», для которых каждый признак представляет собой абсолют Меры различия для бинарных переменных — применяются, если все переменные набора являются бинарными. Для этого случая в компьютерных программах предусмотрен широкий набор бинарных мер различия (Втагу Меа§иге$). Например, в программе 8Р88 предлагается 6 мер для МШ и 27 (!) мер для кластерного анализа. Все эти меры различия основаны на представлении о четырехклеточной таблице сопряженности двух бинарных переменных Хи У:

где а — количество объектов, для которых и по X и по У значения равны 1, и т. д. Приведем некоторые меры различий для бинарных переменных. Квадрат евклидова расстояния (8циагей ЕисШеап йЫапсе)\ й= Ъ + с. Евклидово расстояние (ЕисШеап йШапсе)\ с1 = VЬ + с. Коэффициент сопряженности ср-Пирсона (РМ 4-ро 'т1з согге1а(юп): ай-Ъс ф=, у1(а + Ь)(с + с1)(а + с)(Ь + с1) О-коэффициент Юла (Уи1е'з ()): 0 = ——— аё + Ьс' Величина различий (8'це йЩегепсеу. й =------------------------------ ———---------- г- (|а + Ь + с + с1у' Простой коэффициент совстречаемости (81тр\е та(скм%)\ (1 =------------------------------------------------ —------------ а + Ь + с + й' То, какая мера предпочтительней, зависит оттого, какая роль в исследовании отводится частотам а, в, с и й. НЕМЕТРИЧЕСКАЯ МОДЕЛЬ Это основной вариант многомерного шкалирования, применяемый в настоящее время. Он лежит в основе всех остальных вариантов метода. Исходные данные для этого метода — матрица размерностью РхР, каждый элемент Многомерное шкалирование и исторически, как новый шаг в математике, и процессуально — как последовательность обработки данных компьютерной программой, начинается с метрического шкалирования, предложенного в 50-х годах У. Торгерсоном. В модели Торгерсона вводится жесткое предположение о том, что оценки различия между объектами равны линейному расстоянию между ними в евклидовом пространстве. Пусть 5,у — имеющаяся в распоряжении исследователя оценка различия между объектами / и у. и х]к — координаты этих объектов по оси к, одной из осей искомого пространства размерностью К. Расстояние меледу объектами в искомом пространстве обозначим как йу. Тогда основное предположение Торгерсона можно выразить формулой: (18.1) Торгерсон показал, что при соблюдении этого условия возможен переход от исходной матрицы различий между стимулами к их координатам в пространстве А" признаков. Для этого необходимо прежде всего пересчитать исходную матрицу различий в матрицу «скалярных произведений» — путем двойного центрирования, чтобы среднее значение элементов каждой строки и каждого столбца было равно 0. Элементы такой матрицы обозначим как <5*. Тогда, по Торгерсону, справедливо выражение: к 8* = или в матричной форме: Д* = XX', к=\ где X — матрица координат стимулов, размерностью РкК. Это уравнение аналогично главному уравнению факторного анализа, и решается оно относительно ^методом главных компонент с заданным числом К. В современных алгоритмах МШ метод Торгерсона используется на этапе предварительной оценки координат объектов по матрице исходных различий. Далее следует неметрический этап, соответствующий неметричности исходных данных. На этом этапе исходят из требования соответствия рангового порядка расстояний между объектами в результирующем пространстве ранговому порядку исходных различий, то есть, используя принятые обозначения: ^у ^ 8,у < 5/т для любых /,у, I, т — номеров объектов.

Основной мерой выполнения этого требования является специальный показатель, который называется стресс — мера отклонения итоговой конфигурации объектов от исходных оценок различия в смысле указанного требования рангового соответствия. Иногда дополнительно применяют коэффициент отчуждения тоже как меру подгонки неметрической модели к данным о различии. Не рассматривая подробно вычислительные проблемы многомерного шкалирования, укажем, что его алгоритм направлен на нахождение оценок координат объектов, минимизирующих значение стресса. Построен этот алгоритм как градиентная процедура. Первый шаг алгоритма — получение стартовой конфигурации, как правило, методом Торгерсона. На каждом последующем шаге, или итерации, координаты стимулов изменяются в сторону уменьшения значения стресса, вычисленного на предыдущем этапе. Итерации повторяются многократно, до выполнения одного из трех заданных изначально условий (в программе 8Р88): достижения минимального значения стресса; достижения минимальной разницы между последним и предыдущим значениями стресса; выполнения максимального заданного числа итераций. Каждое из трех условий задано в программе «по умолчанию», но может изменяться пользователем. Уменьшая пороговые величины стресса и его изменения, увеличивая максимальное число итераций, пользователь может добиться повышения точности окончательного решения. Показателем точности является конечная величина стресса. Наиболее приемлемые величины стресса находятся в диапазоне от 0,05 до 0,2. Одна из основных проблем, возникающих перед исследователем в МШ — это проблема размерности К. Как и при проведении факторного анализа, в МШ требуется предварительное определение числа шкал. Поэтому от исследователя требуется получить несколько решений в пространствах разной размерности и выбрать из них лучшее. Один из критериев размерности, применяемый для предварительной оценки числа шкал, аналогичен критерию отсеивания Кеттелла в факторном анализе: строится график зависимости стресса от числа шкал по результатам решения в разных размерностях. Истинная размерность соответствует точке перегиба графика после резкого его спада. Другой критерий числа шкал — абсолютная величина стресса. Если решение одномерно, то приемлемая величина стресса — менее 0,1. Если решение размерностью 2 и выше, то приемлемы значения стресса, меньшие 0,1-0,15. Однако если уровень ошибок измерения или выборки высок, то можно признать решение и с более высокими значениями стресса. Дополнительно вычисляется величина Л[21] (Н.80), которая показывает долю дисперсии исходных различий (от единичной), учтенную выделенными шкалами. Чем ближе К.80 к единице, тем полнее данные шкалы воспроизводят исходные различия между объектами. Окончательный выбор размерности решения определяется на основе критериев интерпретируемости и воспроизводимости, так же, как в факторном анализе. Тем не менее, при размерности 2 и выше, следует избегать решений с величиной стресса выше 0,2. Обычный путь для этого — повышение размерности и исключение объектов. Результаты применения метода — таблица координат объектов в пространстве А" шкал-признаков, величины стресса и Я8(), интерпретация шкал и взаимного расположения объектов по таблице координат. ПРИМЕР 18.1 ____________________________________________________________________ Исследовалась структура представлений студента о многомерных методах, применяемых в психологии. Студенту было предложено сравнить попарно по степени различия пять методов: множественный регрессионный анализ (МРА), дискриминантный анализ (ДА), кластерный анализ (КА), факторный анализ (ФА) и многомерное шкалирование (МШ). При сравнении было предложено использовать 5-балльную шкалу (1 — очень похожи, 5 — совсем разные). Результаты сравнения приведены в табл. 18.4. Таблица 18.4

Обработка на компьютере Для обработки воспользуемся данными примера 18.1. Исходные данные (Ра1а ЕсИ1ог) представляют собой нижний треугольник матрицы попарных различий между 5 объектами (табл. 18.4). 1. Выбираем Апа1уге > 8са1е > МиШ(Нтеп8юпа1 8саНп§ (АЬ8САЬ)... Примечание. В последних версиях 8Р88 наряду с вариантом АЬ8САЬ предлагается более современный вариант многомерного шкалирования РКОХ- 8САЬ. Этот последний вариант, на наш взгляд, действительно более удобен и совершенен. Но поскольку многие пользуются версиями 8Р88, в которых программы РК.ОХ8САЬ еще нет, мы воспользуемся вариантом АЬ8САЬ. Тем более что результаты обработки хоть и различаются, но не существенно. Для тех, кому доступна программа РКОХ8САЬ, не составит большого труда перейти к ней после знакомства с программой АЬ8САЬ. применяется несимметричная квадратная матрица различий, например, как результат социометрии. В этом случае указывается соответствующая опция: 8Ьаре... 8диаге а5утте(пс. 3. Нажимаем кнопку Мойе1... (Модель...) и задаем параметры модели шкалирования. Главным параметром здесь является количество шкал. Обычно следует получить результаты для нескольких шкал и выбрать наилучшее из них — по величинам стресса и по отчетливости интерпретации. В данном случае у нас всего 5 объектов, поэтому вряд ли потребуется более двух шкал. Задаем Ошепкюпк (Шкалы) Мшшшп: 2, Махшит: 2. Параметры Ьеуе! оГ теа$игетеп((Уровень измерения) можно не менять и оставить принятые по умолчанию ОпНпа): (Порядковый:) их изменение практически не меняет результаты. Разве что можно поставить флажок ШЫе Ней оЬзегуаНоп (Корректировать связанные наблюдения) — для устранения влияния связей (повторов) в рангах. Убеждаемся, что установлено СопйШопаШу: Ма1пх (Условие подгонки: вся матрица). После задания всех параметров модели нажимаем СопШие. 4. В основном окне диалога нажимаем Орйопк (Опции) для задания параметров обработки и вывода результатов. В появившемся окне диалога внизу в поле 0|$р1ау (Выводить) отмечаем флажком Сгоир р1о{$ (Графики для всей группы) — для графического отображения объектов в координатах шкал. В поле СгКепа (Критерии) указаны критерии для итераций по подгонке модели: §-8(ге88 сопуег§епсе: 0,001 (Величина сходимости з-стресса), Мттшт 8-8*ге88 уа1ие: 0,005 (Минимальная величина з-стресса), Махшшт кегаШтв: 30 (Максимальное количество итераций). Эти величины можно не менять. П р и м е ч а н и е. В поле СгНепа (Критерии) минимальная величина стресса явно занижена: вполне достаточна величина 0,1. Для увеличения точности решения можно увеличить количество итераций и уменьшить величину сходимости стресса (разности стресса на последней и предыдущей итерациях). Но при этом следует внимательно просмотреть по результатам «историю» итераций, так как там могут быть локальные минимумы величины стресса. После задания всех параметров обработки и вывода результатов нажимаем СопНпие. Нажимаем ОК и получаем результаты. 5. Основные результаты МШ. А) «История» итераций, величины стресса и К.80: 11:егаЬ10п МзСогу Еог СЬе 2 сИтепз:.опа1 во1иЬ1оп (История итераций для 2-шкального решения.) Уоипд'з З-зЬгезз Еогти1а 1 13 изе (Применена формула 5-стресса Юнга.) 1Ьега(:1оп З-зЬгезз 1тргоуетепЬ (Итерация) (5-стресс) (Улучшение) 1.00000 1Ьега(;10П8 зЬоррей Ьесаиве З-зЪгезз 13 1езз ЬЬап.005000 (Итерации остановлены, поскольку 8-стресс меньше, чем 0,005.) ЗСгезз Vа1иез аге Кгизка1'з зСгезз Еогши1а 1. (Величина стресса вычислена по формуле 1 Краскала.) Рог таЬггх (Для всей матрицы) ЗЬгезз =.00000 К5<Э = 1.00000. История итераций показывает, что минимальная величина достигнута уже на первом шаге, что на самом деле встречается очень редко. Обычно при большем количестве объектов проблемой является слишком большая величина стресса. Окончательная величина стресса (по формуле 1 Краскала) и величина свидетельствуют о полном соответствии решения исходным данным.

В) Координаты объектов в осях шкал:

-0,5 см с о м -1,0 с Ф Е Ь -1,5 Величина стресса и К.5<3 свидетельствуют о достаточно точной подгонке конечной конфигурации к исходным данным (расстояния между объектами в итоговом пространстве соответствуют исходным различиям). Следовательно, можно приступать к содержательной интерпретации результатов. На положительном полюсе первой шкалы располагаются МРА и ФА, на отрицательном — КА и МШ. Промежуточное положение занимает ДА. Таким образом, эта шкала отражает наличие знаний у студента о различии методов по исходным предположениям о структуре данных: ФА, МРА и отчасти ДА исходят из согласованности изменчивости признаков (корреляций), а КА и МШ — из дистантной модели (мер сходства или различия). На положительном полюсе второй шкалы располагаются ДА и КА — методы классификации, на отрицательном полюсе — ФА и МШ, структурные методы. Следовательно, наличие этой шкалы свидетельствует о сформированное™ у студента адекватных знаний о назначении многомерных методов. Наглядное представление о субъективной структуре знаний студента дает график координат сравниваемых объектов в пространстве двух шкал. МОДЕЛЬ ИНДИВИДУАЛЬНЫХ РАЗЛИЧИЙ Этот метод — расширение метода неметрического МШ путем включения в основную модель субъективных параметров. Оценки индивидуальных различий дают, наряду с координатами стимулов, количественное координатное описание субъектов, аналогичное координатному описанию стимулов, получаемому с помощью неметрического МШ. Исходными данными для МШ индивидуальных различий является N матриц оценок различий Р объектов- стимулов, то есть результат оценки попарных различий Р объектов каждым из А'испытуемых. Индивидуальная матрица различий для каждого испытуемого может быть получена и в результате вычисления матрицы РхР по результатам сравнения испытуемым Робъектов по ряду признаков. Типичный пример последнего — обработка репертуарных решеток Келли, когда исходными данными являются оценки объектов (например, ролей) по совокупности конструктов. Такой вид анализа легко осуществим при помощи компьютерной программы РК.ОХ- 5САЦ входящей в состав 8Р85. В модели предполагается, что существует общая для всех испытуемых групповая матрица координат объектов — X, размерностью Рх К(Р— число объектов, К — число координат). При этом для каждого испытуемого имеется индивидуальная матрица координат Х! той же размерности, но по содержанию отличающаяся от групповой. Можно представить себе координаты групповой матрицы как совокупность общих (групповых) точек зрения на объекты. Тогда индивидуальная матрица будет отличаться от групповой степенью учета данным испытуемым этих общих точек зрения, иначе — индивидуальным весом общих координат. Таким образом, предполагается, что элементы каждой субъективной матрицы координат отличаются от элементов групповой матрицы индивидуальными весовыми коэффициентами — мерами того, насколько учитываются Каждый субъект может быть охарактеризован набором индивидуальных весов... данным субъектом общие точки зрения. А каждый субъект может быть охарактеризован набором индивидуальных весов — по одному для каждой координаты (точки зрения). Индивидуальные веса иногда называют весами важности, весами характеристик или масштабными коэффициентами. При прочих равных условиях, при увеличении индивидуального веса данной координаты разность между стимулами по этой координате вносит все больший и больший вклад в оцениваемое различие между этими стимулами. Изложенное выше можно представить в виде формальных соотношений. Обозначим через х1к координату объекта / по шкале к в общем групповом пространстве объектов. Предполагается, что соответствующий элемент субъективной матрицы координат х1к5 для испытуемого 5 связан с элементом групповой матрицы соотношением хИа ~ Хцс^кз или в матричных обозначениях: х3 = хт, где и^ — вес координаты к для субъекта — матрица субъективных весов для всех А"координат, преобразующая групповую матрицу в индивидуальную.

В соответствии с моделью индивидуальных различий исходные данные о субъективном различии объектов / и / субъектом 5 выражаются формулой

1а(хНс '

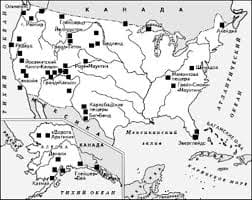

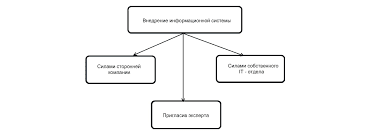

Эта формула выражает основное предположение модели МШ индивидуальных различий и связывает исходные данные о субъективных оценках различий 5 с результатами применения метода: групповой матрицей координат объектов X, размерностью Рх К, и матрицей субъективных (индивидуальных) весов IV, размерностью УУх К. При этом матрица Xаналогична ре   Система охраняемых территорий в США Изучение особо охраняемых природных территорий(ООПТ) США представляет особый интерес по многим причинам...  Что делает отдел по эксплуатации и сопровождению ИС? Отвечает за сохранность данных (расписания копирования, копирование и пр.)...  ЧТО ПРОИСХОДИТ ВО ВЗРОСЛОЙ ЖИЗНИ? Если вы все еще «неправильно» связаны с матерью, вы избегаете отделения и независимого взрослого существования...  Что способствует осуществлению желаний? Стопроцентная, непоколебимая уверенность в своем... Не нашли то, что искали? Воспользуйтесь поиском гугл на сайте:

|