|

|

Спектральное разложение стационарной случайной функцииУстойчивость стационарного случайного процесса во вре- мени позволяет заменить исследование стационарной функции времени исследованием случайной функции некоторой вспомо- гательной переменной, которая во многих приложениях имеет размерность частоты. Полученные таким способом результаты оказываются полностью эквивалентными результатам, получае- мым с помощью корреляционной функции случайного процесса, однако применение этого способа во многих случаях позволяет значительно упростить выкладки и добиться большей наглядно- сти результатов. Частным случаем этого широко известного ме- тода является метод преобразования Фурье. Распространение этого метода на случайные функции называют методом спек- тральных представлений. Понятие спектра встречается не только в теории случайных функций; оно широко применяется в математике, физике и техни- ке. Если какой-либо колебательный процесс представляется в виде суммы гармонических колебаний различных частот (так называе- мых гармоник), то спектром колебательного процесса называется функция, описывающая распределение амплитуд по различным частотам. Спектр показывает, какого рода колебания преобладают в данном процессе, какова его внутренняя структура. Совершенно аналогичное спектральное описание можно дать и стационарному случайному процессу, вся разница в том, что для случайного процесса амплитуды колебаний будут случайными ве- личинами. Спектр стационарной случайной функции будет описы- вать распределение дисперсий по различным частотам. Однако применение гармонического анализа непосредст- венно к случайным процессам неприемлемо, так как стационар- ный случайный процесс не затухает во времени и не удовлетво- ряет некоторым условиям, необходимым для представления его интегралом Фурье. Но так как характеристики случайного процесса детерминированны, то к ним применима теория инте- гралов Фурье. Впервые А.Я. Хинчиным было доказано, что любой ста- ционарный случайный процесс можно рассматривать как нало- жение некоррелированных друг с другом гармонических коле- баний различных частот со случайными фазами и амплитудами. К понятию о спектре случайной функции можно подойти из следующих соображений. Рассмотрим стационарную центри- рованную случайную функцию X (t) на интервале (0, T). Учи- тывая, что корреляционная функция рассматриваемой функции четная, ее можно разложить на интервале (– T, T), используя только четные гармоники, т.е.

Kx (t) = å Di cosw i t, i =0 (2.25)

где

w – частота i -й гармоники, w = i w, w = 2p= p;

i

i 1 1 2 T T

ò Kx (t) d t; - T Di = 2 T ò Kx (t) cosw i t d t при i ¹ 0. Перейдем от аргумента t к двум переменным t 1 и t 2 (t= t 2 - t 1) и подставим в формулу (2.25), получим:

i =0 (2.26) Но выражение (2.26) есть не что иное, как каноническое разложение корреляционной функции, координатными функ- циями которого являются косинусы и синусы частот, кратных w1. Зная каноническое разложение корреляционной функции, можно построить каноническое разложение самой случайной функции с теми же координатными функциями и с дисперсия- ми, равными коэффициентам Di корреляционной функции: ¥ в каноническом разложении X (t) = å(Ui cosw it 1cosw it 2+ Vi sin w it 1sin w it 2), i =0 (2.27) где Ui, Vi – некоррелированные центрированные случайные ве- личины, для которых

D (Ui) = D (Vi) = Di. Разложение (2.27) называется спектральным разложением стационарной случайной функции (изображает стационарную случайную функцию, разложенную на гармонические колебания различных частот, причем амплитуды этих колебаний являются случайными величинами). Дисперсия случайной функции (2.27) ¥ ¥

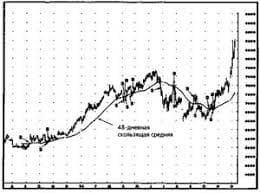

i =0 i =0 Таким образом, дисперсия стационарной случайной функ- ции равна сумме дисперсий всех ее гармоник спектрального разложения, т.е. дисперсия Dx известным образом распределена по разным частотам: одним частотам соответствуют большие дисперсии, другим – меньшие. Распределение по частотам мож- но проиллюстрировать графически в виде так называемого спектра дисперсий (рис. 2.6, а), представляющего собой ряд от- дельных дискретных линий, разделенных равными промежут- ками (Dw = w = p). Сумма всех ординат построенного спектра

1 T равна дисперсии случайной величины. Наши знания о случайной функции будут тем полнее, чем больший участок времени мы будем рассматривать, поэтому перейдем в разложении к пределу T ® ¥. В этом случае рас- стояние между частотами Dw будет неограниченно уменьшать- ся, а дискретный спектр будет приближаться к непрерывному (рис. 2.6, б). При построении этого графика будем откладывать по оси ординат не саму дисперсию Di, а среднюю плотность дисперсии, т.е. дисперсию, приходящуюся на единицу длины данного интервала частот (на каждом отрезке Dw, как на осно- вании, строим прямоугольник с площадью Di). Получаем сту- пенчатую диаграмму. Высота прямоугольника на участке Dw, прилежащем к точке w i,

и представляет собой среднюю плотность дисперсии на этом участке. Суммарная площадь всей диаграммы, очевидно, равна дисперсии случайной функции.

Рис. 2.6

При неограниченном увеличении интервала ступенчатая кривая будет неограниченно приближаться к плавной кривой Sx (w) (рис. 2.6, в). Эта кривая изображает плотность распреде- ления дисперсии по частотам непрерывного спектра, а сама функция Sx (w) называется спектральной плотностью дисперсии или спектральной плотностью стационарной центрированной случайной функции X (t). Очевидно, площадь, ограниченная кривой Sx (w), по-прежнему должна равняться дисперсии Dx случайной функции X (t): ¥ Dx = ò Sx (w) d w. (2.28)

Формула (2.28) есть не что иное, как разложение дисперсии Dx на сумму элементарных слагаемых Sx (w) d w. Таким образом, мы ввели в рассмотрение новую дополни- тельную характеристику стационарного случайного процесса – спектральную плотность, описывающую частотный состав ста- ционарного процесса. Однако эта характеристика не является самостоятельной; она полностью определяется корреляционной функцией данного процесса. Подобно тому, как ординаты дис- кретного спектра Di выражаются формулой (2.25) через корре- ляционную функцию Kx (t), спектральная плотность Sx (w) также может быть выражена через корреляционную функцию: 2 ¥

(2.29) В ряде случаев с точки зрения простоты математических преобразований оказывается удобным пользоваться не действи- тельной, а комплексной формой записи как спектрального раз- ложения случайной функции, так и ее характеристик: спек- тральной плотности и корреляционной функции. Комплексная форма записи удобна, в частности, потому, что всевозможные линейные операции над функциями, имеющими вид гармониче- ских колебаний (дифференцирование, интегрирование, решение линейных дифференциальных уравнений и т.д.), осуществляют- ся гораздо проще, когда эти гармонические колебания записаны не в виде синусов и косинусов, а в комплексной форме, в виде показательных функций. Комплексная форма записи корреля- ционной функции и спектральной плотности применяется и в тех случаях, когда сама случайная функция (а следовательно, и ее корреляционная функция и спектральная плотность) дейст- вительна. Корреляционная функция стационарного эргодического случайного процесса в комплексном виде может быть представ- лена интегралом Фурье: ¥ Kx (t) = ò Sx (w)e i wt d w, -¥

(2.30) где Sx (w) – неслучайная функция (спектральная плотность слу- чайного процесса X (t)). Выполняя обратное преобразование, будем иметь:

¥

d t.

(2.31) 2p-¥ Используя эти соотношения, можно установить важную за- висимость между дисперсией и спектральной плотностью: ¥ Kx (0) = Dx = ò Sx (w) d w. -¥

(2.32) Формулы (2.29) и (2.30) называются формулами Винера – Хинчина. Покажем, как можно вычислять спектральные плотности производных стационарных функций. Подставляя в формулы (2.11) соотношение (2.29), получим:

или ¥ Kx &(t) = ò Sx (w) w2e i wt d w, -¥

(2.33)

(2.34)

Аналогично получаем спектральную плотность второй производной:

X (t) имеет вид: K (t) = D e-atcosbt (рис. 2.7, а). Определить

Рис. 2.7

Решение. Представляем Kx (t) в комплексной форме:

Kx (t) = D e 2. Спектральную плотность Sx (w) находим по формуле (2.31):

- bt Sx (w) = òe e i d t =

D ìï0 at 2p -¥ 2 ¥ üï = íòe (e i bt +e- i bt)e- i wt d t+òe-at (e i bt +e- i bt)e- i wt d tý.

4pïî-¥ 0 ïþ Отсюда после элементарных преобразований получаем: S (w) = D ì a

+ a ü.

p îa + (w + b) a + (w - b) þ Вид графика спектральной плотности (рис. 2.7, б) зависит от соотношения параметров a и b, т.е. от того, что преобладает

бание по закону cosbt. Очевидно, при сравнительно малых a преобладает колебание, при сравнительно больших a – убыва- ние. В первом случае случайная функция близка к периодиче- ским колебаниям частоты b со случайной амплитудой и фазой; соответственно, в спектре случайной функции преобладают час- тоты, близкие к частоте b. Во втором случае спектральный со- став случайной функции более равномерен, преобладания тех или иных частот не наблюдается; в пределе при a ® ¥ спектр случайной функции приближается к спектру белого шума. В качестве иллюстрации на рис. 2.7, б изображены спек- тральные плотности для следующих случаев: 1) b = 2, a = 1 (кривая I); 2) b= 2, a = 3 (кривая II). Как видно из чертежа, при a = 1 спектр случайной функции обнаруживает ярко выражен- ный максимум в области частот w = ±b. При a = 3 (кривая II) спектральная плотность в значительном диапазоне частот оста- ется почти постоянной. В прил. 2 приведены виды случайных функций и соответ- ствующих им корреляционных и спектральных функций, а в прил. 3 их математическое описание. В рамках приведенных определений можно привести ре- шение задачи надежности (задача о выбросах) и задачи о сво- бодных линейных колебаниях систем.

Марковские процессы Корреляционная теория позволяет провести анализ систем с линейной связью между входом и выходом. В этом случае кор- реляционная теория дает возможность получить вероятностные характеристики решения дифференциальных уравнений, если известны вероятностные характеристики возмущений. Однако получить решение нелинейных уравнений на основе корреляци- онной теории нельзя. Не всегда удается решить и задачу об опре- делении вероятности превышения ординатой случайной функции заданных значений. Во всех этих случаях могут быть полезны марковские процессы, для полной характеристики которых дос- таточно знать только двумерные законы распределения. Случайный процесс называется марковским, если распре- деление в момент времени t 2 может быть выражено через рас- пределение в предшествующий момент времени t 1 < t 2 независи- мо от предшествующей истории процесса. Таким образом, мар- ковский процесс – это процесс без последействия. Марковские процессы являются абстракцией реальных процессов. Однако многие реальные процессы могут приближенно трактоваться как марковские или, во всяком случае, могут рассматриваться как компоненты многомерных марковских процессов. Выделение марковских процессов в отдельный класс вызвано рядом причин, важнейшими из которых являются отно- сительная простота случайного процесса, описывающего эво- люцию системы, наличие возможности использовать хорошо разработанный математический аппарат для аналитического исследования марковских процессов, возможность получения аналитических выражений для показателей качества систем и, наконец, возможность сведения к указанным процессам более общих процессов.

начальной (при t = t 0) плотно- стью распределения вероятно- стей f (x 0) (рис. 2.8). Распро-

Рис. 2.8 страняя соотношение (1.9) на многомерный случай, запишем плотность распределения этого процесса в следующем виде:

где f (xn x 0, x 1,..., xn -1) – условная плотность вероятности xn при условии, что в предыдущие моменты времени процесс x (t) ха- рактеризовался значениями x 0, x 1,..., xn -1. Процесс называется марковским, если

xn -1), (2.36)

т.е. если значение случайного процесса в некоторый момент времени зависит только от предыдущего значения. Тогда многомерная плотность распределения

(2.37)

цию f (xi, ti xi -1, ti -1), равную условной плотности вероятности перехода из состояния xi -1 в состояние xi, называют еще пере- ходной плотностью вероятности. Можно получить интеграль- ное, а затем дифференциальное уравнение, которому должна удовлетворять переходная плотность вероятности. Ранее (см. (1.9)) было показано, что одномерную плотность вероятности можно получить через двумерную. Тогда, рассмат- ривая три последовательных момента времени: но записать: t 0 < t 1 < t 2, мож- ¥ f (x 2, t 2, x 0, t 0) = ò -¥

f (x 2, t 2, x 1, t 1, x 0, t 0) dx 1. Согласно соотношению (2.37) будем иметь:

¥

-¥

¥

-¥

f (x 2, t 2 x 1, t 1) f (x 1, t 1 x 0, t 0) dx 1.

(2.38) Уравнение (2.38) в математической литературе называют уравнением Чепмена – Колмогорова, в литературе по физике – уравнением Смолуховского, который получил его при исследо- вании броуновского движения частицы. Уравнение (2.37) накла- дывает весьма жесткие ограничения на вид условной плотности вероятности перехода, а именно: интегрирование по х 1 должно привести к исключению х 1, причем вид функции f должен ос- таться неизменным. Пределы интегрирования не обязательно должны быть равны бесконечности. Получим дифференциальное уравнение, которому должна удовлетворять условная плотность вероятности перехода. В дальнейшем будем рассматривать непрерывный случайный процесс (процесс х (t) считается непрерывным, если за малые промежутки времени D t функция х (t) может получить заметные по величине приращения лишь с малой вероятностью). Далее в уравнении (2.38) заменим: t 1 = t 0 + D t (D t > 0) и t 2 = t,

¥

-¥

f (x, t x 1, t 0 + D t) f (x 1, t 0 + D t x 0, t 0) dx 1. (2.39) Разложим теперь функцию f (x, t x 1, t 0 + D t) в ряд Тейлора

+ D t) + ¶ f (x - x) +

¶ x 0

¶3

+... 0 0

Подставив полученное соотношение в (2.38) и проведя ряд преобразований [20], получим уравнение

¶ f + b ¶2 f + c ¶3 f

a 1 1 1, (2.40) ¶ t ¶ x 2 ¶ x 2 6 ¶ x 3 0 0 0 0 где

1 ¥

a 1 = a 1 (x 0, t 0) =

M [(z - x)]

0 0 D t ®0 D t

= lim (z - x) f (z, t -¥ + D t x, t) dz º lim 0; b 1 = b 1 (x 0, t 0) = 1 ¥

M [(z - x)2 ]

0 0 D t ®0 D t

= lim (z - x)2 f (z, t -¥ + D t x, t) dz º lim 0; c 1 = c 1 (x 0, t 0) = 1 ¥

M [(z - x)3 ]

0 0 D t ®0 D t

= lim (z - x)3 f (z, t -¥ + D t x, t) dz º lim 0. В полученных соотношениях операция М [ ] есть операция условного математического ожидания. Коэффициент а 1 характе- ризует скорость изменения случайной функции, а b 1 – скорость

ятность больших отклонений z - x 0 убывает с уменьшением D t настолько быстро, что все моменты этой разности, начиная с третьего, стремятся к нулю быстрее, чем D t. Следовательно, решение уравнения (2.40) справедливо (при с 1 = 0) только для ин- тервалов времени D t, много больших интервалов времени между скачками. Окончательно получаем уравнение в виде (первое уравнение Колмогорова):

¶ f + b ¶2 f

a 1 1. (2.41) ¶ t ¶ x 2 ¶ x 2 0 0 0

плотность вероятности f (x, t x 0, t 0) как функцию начального состояния (независимыми переменными являются x 0 и t 0). Уравнение, позволяющее определить изменение условной плотности вероятности в будущем (т.е. независимыми пере- менными являются x и t), называется вторым уравнением Колмогорова (или уравнением Фоккера – Планка – Колмогоро- ва) и имеет вид [20] ¶ f ¶(a f) 1 ¶2 f (b f) + 1 - 1 = 0.

(2.42) ¶ t ¶ x 2 ¶ x 2 Чтобы применить аппарат теории марковских процессов к задачам статистической динамики, необходимо установить класс систем, поведение которых может рассматриваться как непрерывный марковский процесс. Очевидно, что должны быть наложены существенные ограничения на оператор связи пара- метров системы с нагрузкой L [ x (t)] = q (t). Пусть x (t) определяет одномерный процесс, а L является дифференциальным оператором. Нетрудно заметить, что пове- дение системы в любой момент времени не будет зависеть от истории состояния только в том случае, если L имеет первый порядок (поведение в этом случае зависит только от начального состояния), т.е. дифференциальное уравнение относительно x (t) должно иметь вид: x &+ f (t) = q (t). (2.43)

Здесь f (t) – неслучайная функция. Кроме того, внешнее воздействие q (t) должно быть дельта-коррелированным; в про- тивном случае история системы будет влиять на ее поведение через стохастическую связанность воздействия. Итак, внешнее воздействие q (t) должно быть белым шумом с известными веро- ятностными характеристиками mq = 0, Kq = S 0d(t). Изложенную теорию можно обобщить на многомерные марковские процессы, что позволяет решать задачи в случаях, когда дифференциальный оператор имеет, например, второй или более высокий порядок. Задачи для самостоятельного решения 1. Определить нормированную корреляционную функцию, если X (t) = A e-a t, где А – случайная величина с известным ма- тематическим ожиданием mA и дисперсией DA. 2. Определить, является ли случайная функция

X (t) =

= å(Ai cosw it + Bi sin w it) i =1 стационарной, если Ai и Bi

– случай- ные взаимно независимые величины с нулевыми математиче- скими ожиданиями и равными дисперсиями (DA = DB = Di). i i 3. Определить корреляционную функцию случайной функции

Y (t) = a (t) X (t) + dX (t) b (t), dt где a (t), b (t) – неслучайные функции; X (t) – случайная функция с известными характеристиками: mх = 0 и Kx (t 1, t 2). 4. Балка длиной l, изображенная на рисунке, имеющая по- стоянную изгибную жесткость EI, нагружена случайной попе- речной силой q с извест-

5. ми числовыми характери- стиками. Определить мате- матическое ожидание и дисперсию максимального прогиба.

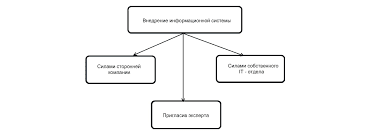

Что вызывает тренды на фондовых и товарных рынках Объяснение теории грузового поезда Первые 17 лет моих рыночных исследований сводились к попыткам вычислить, когда этот...  Живите по правилу: МАЛО ЛИ ЧТО НА СВЕТЕ СУЩЕСТВУЕТ? Я неслучайно подчеркиваю, что место в голове ограничено, а информации вокруг много, и что ваше право...  ЧТО ПРОИСХОДИТ ВО ВЗРОСЛОЙ ЖИЗНИ? Если вы все еще «неправильно» связаны с матерью, вы избегаете отделения и независимого взрослого существования...  Что делает отдел по эксплуатации и сопровождению ИС? Отвечает за сохранность данных (расписания копирования, копирование и пр.)... Не нашли то, что искали? Воспользуйтесь поиском гугл на сайте:

|